Theo vết đối tượng trong video dựa trên độ lợi thông tin

Theo vết đối tượng trong video là một bài toán quan trọng cốt yếu trong lĩnh vực thị giác

máy tính. Theo vết chuyển động của đối tượng có thể sử dụng trong các hệ thống an ninh,

quan sát tự động, tích hợp vào robot, các thiết bị bay không người lái của quân đội,. Bài báo

này trình bày hướng tiếp cận mô tả bài toán dưới dạng lọc một quá trình ngẫu nhiên Markov

ẩn, sử dụng particle filter để lọc quá trình ngẫu nhiên và kết hợp giữa việc tính toán điểm tự

tin từ gentle adaboost. Nhóm tác giả đề xuất thuật toán InfoPart cho phép theo vết đối tượng

bằng phương pháp theo vết phần chứa nhiều thông tin đối tượng hơn (phần đầu, thân) là phần

ít thay đổi theo thời gian và bỏ qua phần chứa ít thông tin (phần chân) là phần dao động nhiều.

Kết quả thực nghiệm cho thấy độ chính xác trung bình của thuật toán InfoPart lớn hơn so với

thuật toán GradNet.

Trang 1

Trang 2

Trang 3

Trang 4

Trang 5

Trang 6

Trang 7

Trang 8

Trang 9

Trang 10

Tải về để xem bản đầy đủ

Tóm tắt nội dung tài liệu: Theo vết đối tượng trong video dựa trên độ lợi thông tin

Tạp chí Khoa học Công nghệ và Thực phẩm 20 (4) (2020) 76-88

76

THEO VẾT ĐỐI TƯỢNG TRONG VIDEO

DỰA TRÊN ĐỘ LỢI THÔNG TIN

Ngô Dương Hà, Trần Như Ý, Lê Hữu Hà,

Nguyễn Phương Hạc, Nguyễn Văn Tùng*

Trường Đại học Công nghiệp Thực phẩm TP.HCM

*Email: tungnv@hufi.edu.vn

Ngày nhận bài: 20/5/2020; Ngày chấp nhận đăng: 12/8/2020

TÓM TẮT

Theo vết đối tượng trong video là một bài toán quan trọng cốt yếu trong lĩnh vực thị giác

máy tính. Theo vết chuyển động của đối tượng có thể sử dụng trong các hệ thống an ninh,

quan sát tự động, tích hợp vào robot, các thiết bị bay không người lái của quân đội,... Bài báo

này trình bày hướng tiếp cận mô tả bài toán dưới dạng lọc một quá trình ngẫu nhiên Markov

ẩn, sử dụng particle filter để lọc quá trình ngẫu nhiên và kết hợp giữa việc tính toán điểm tự

tin từ gentle adaboost. Nhóm tác giả đề xuất thuật toán InfoPart cho phép theo vết đối tượng

bằng phương pháp theo vết phần chứa nhiều thông tin đối tượng hơn (phần đầu, thân) là phần

ít thay đổi theo thời gian và bỏ qua phần chứa ít thông tin (phần chân) là phần dao động nhiều.

Kết quả thực nghiệm cho thấy độ chính xác trung bình của thuật toán InfoPart lớn hơn so với

thuật toán GradNet.

Từ khóa: Boostrap, mô hình Markov ẩn, gentle adaboost, particle filter, Haar like.

1. TỔNG QUAN

Bài toán theo vết đối tượng trong video được áp dụng trong nhiều lĩnh vực khác nhau,

được sử dụng như một bài toán độc lập hay là một bài toán thành phần của bài toán lớn hơn.

Ví dụ, trong lĩnh vực thể thao, việc theo dõi tự động cầu thủ chuyển động là một vấn đề quan

trọng nhằm thuận tiện cho việc phân tích chiến thuật. Bài toán ở đây bao gồm việc phát hiện

cầu thủ rồi sau đó theo vết chuyển động của cầu thủ này. Một ứng dụng cụ thể khác của bài

toán là ứng dụng trong hệ thống xe lái tự động; Việc quan sát và theo vết các xe phía trước là

một phần không thể thiếu để đảm bảo an toàn. Vì vậy, bài toán theo vết nếu kết hợp thêm với

các hệ thống nhận diện, nhận dạng sẽ tạo ra một hệ thống có thể giải quyết nhiều vấn đề trong

cuộc sống.

Hướng tiếp cận bộ lọc tương quan là công cụ mạnh mẽ trong xử lý tín hiệu số. Lớp thuật

toán này xoay quanh việc khai thác các tính chất của biến đổi Fourier, tiêu biểu là tính chất

biến phép tích chập trong miền không gian thành phép nhân hàm số trong miền Fourier [1-4].

Ý tưởng ban đầu của bộ lọc tương quan dùng để giải quyết bài toán định vị một vật trong ảnh.

Nghĩa là, nếu vật được quan tâm có xuất hiện trong ảnh thì xác định vị trí của nó. Công cụ giải

quyết bài toán này là Average of synthetic exact filters (ASEF) [1]. Bộ lọc tương quan tiếp

theo là Minimun Output Sum of Squared Error (MOSSE) được nghiên cứu bởi David S. Bolme

và các cộng sự [4]. Phương pháp theo vết này rất mạnh mẽ, có thể đối phó với các tình huống

thay đổi ánh sáng, thay đổi kích cỡ, hình dáng của vật. Hơn thế nữa, tốc độ thực thi của phương

pháp này rất ấn tượng khoảng 669 fps.

Theo vết đối tượng trong video dựa trên độ lợi thông tin

77

Hướng tiếp cận dựa trên phân loại nền và đối tượng sử dụng adaboost có công trình

nghiên cứu của Shai Aviden [5] tại Mitsubishi Electric Research Labs xem xét việc theo vết

đối tượng là bài toán phân loại nhị phân giữa các pixels nền và vật cần theo vết. Ý tưởng

phương pháp là huấn luyện các hàm phân loại yếu để phân loại nền và vật rồi sau đó kết hợp

lại để tạo thành một phân loại mạnh dựa trên cơ chế adaboost. Tuy nhiên, nhóm tác giả nhận

thấy nếu vật không có dạng hình chữ nhật thì có những pixels thuộc khung hình chữ nhật chứa

vật nhưng không thuộc vật sẽ được gán nhãn thuộc vật. Các pixels này được xem là các phần

tử ngoại lai, adaboost thì lại nhạy cảm với các phần tử ngoại lai [6]. Ngoài ra, một số hạn chế

khác của hướng tiếp cận: chưa giải quyết được tình huống vật bị che khuất hoàn toàn trong

thời gian dài, vẫn phải đánh đổi giữa hiện tượng bị trôi đối tượng và khả năng thích nghi của

mô hình theo thời gian, không gian đặc trưng được sử dụng trong thuật giải chưa tận dụng

được thông tin về không gian của ảnh.

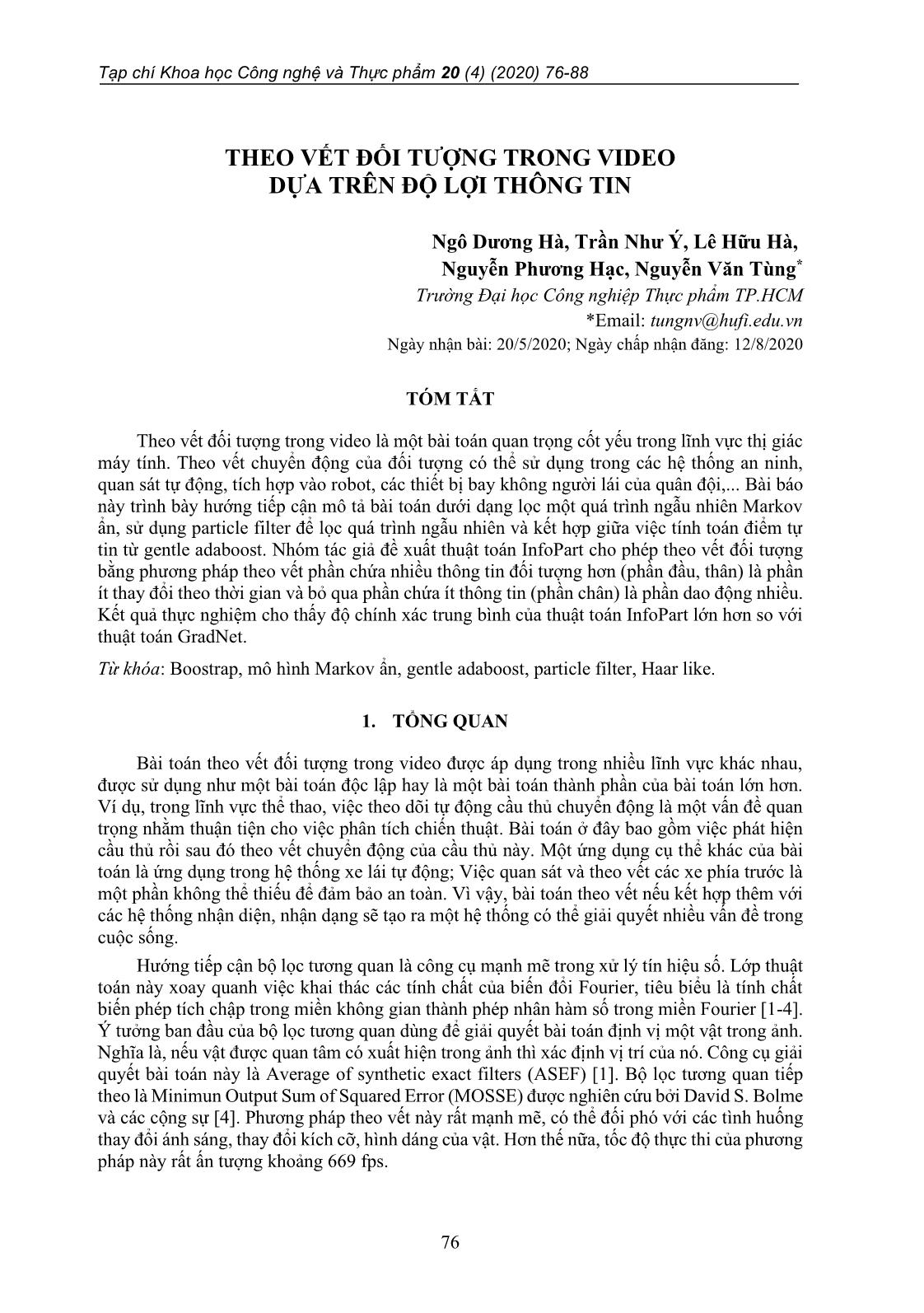

Hướng tiếp cận dựa trên lọc quá trình ngẫu nhiên đã được nghiên cứu trong thời gian dài

trong lĩnh vực thống kê toán học và đã có rất nhiều kết quả ấn tượng được khám phá [7-9]. Đa

số các thuật toán theo hướng tiếp cận này đều dựa trên lời giải tối ưu Bayes cho bài toán lọc

quá trình Markov ẩn [10-12]. Nghĩa là xây dựng mô hình Markov ẩn đóng vai trò then chốt,

mô hình càng chính xác với thực tế thì lời giải Bayes càng ước lượng được chính xác trạng

thái của đối tượng. Công trình [11] có sử dụng đặc trưng về histogram màu sắc để xây dựng

một particle filter để theo vết vật. Công trình [13] sử dụng gentle adaboost để xây dựng mô

hình quan sát cập nhật theo thời gian.

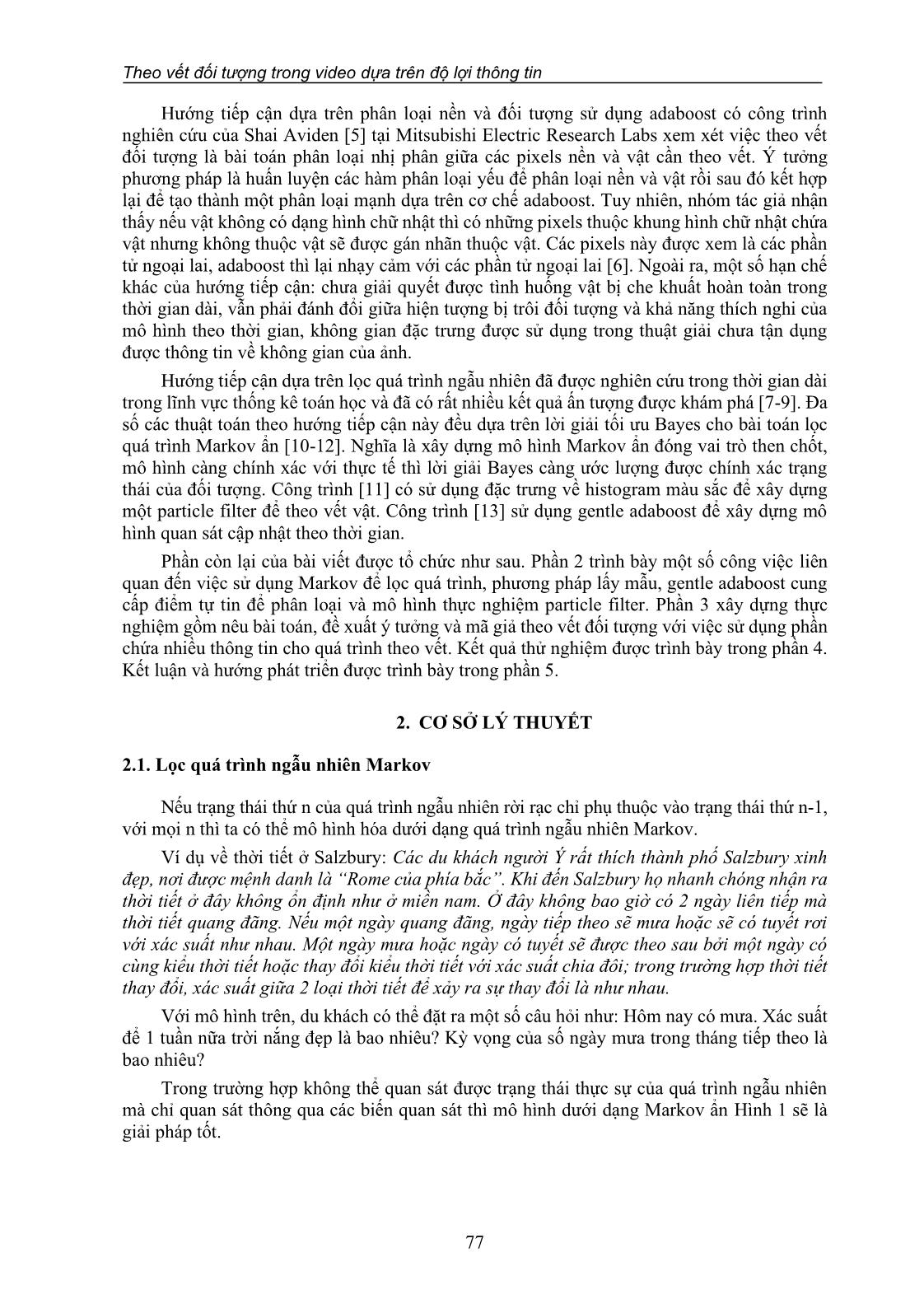

Phần còn lại của bài viết được tổ chức như sau. Phần 2 trình bày một số công việc liên

quan đến việc sử dụng Markov để lọc quá trình, phương pháp lấy mẫu, gentle adaboost cung

cấp điểm tự tin để phân loại và mô hình ... trùng với hàm chuyển trạng thái. Ngoài ra, trong quá

trình thực nghiệm tác giả nhận thấy nếu xem w và h độc lập nhau thì quá trình theo vết không

ổn định. Do đó, xem h phụ thuộc hoàn toàn vào w, nghĩa là tỷ lệ h/w luôn bảo toàn và bằng tỷ

lệ 𝜂 = ℎ/𝑤 của khung hình chữ nhật chứa vật ở ảnh ban đầu.

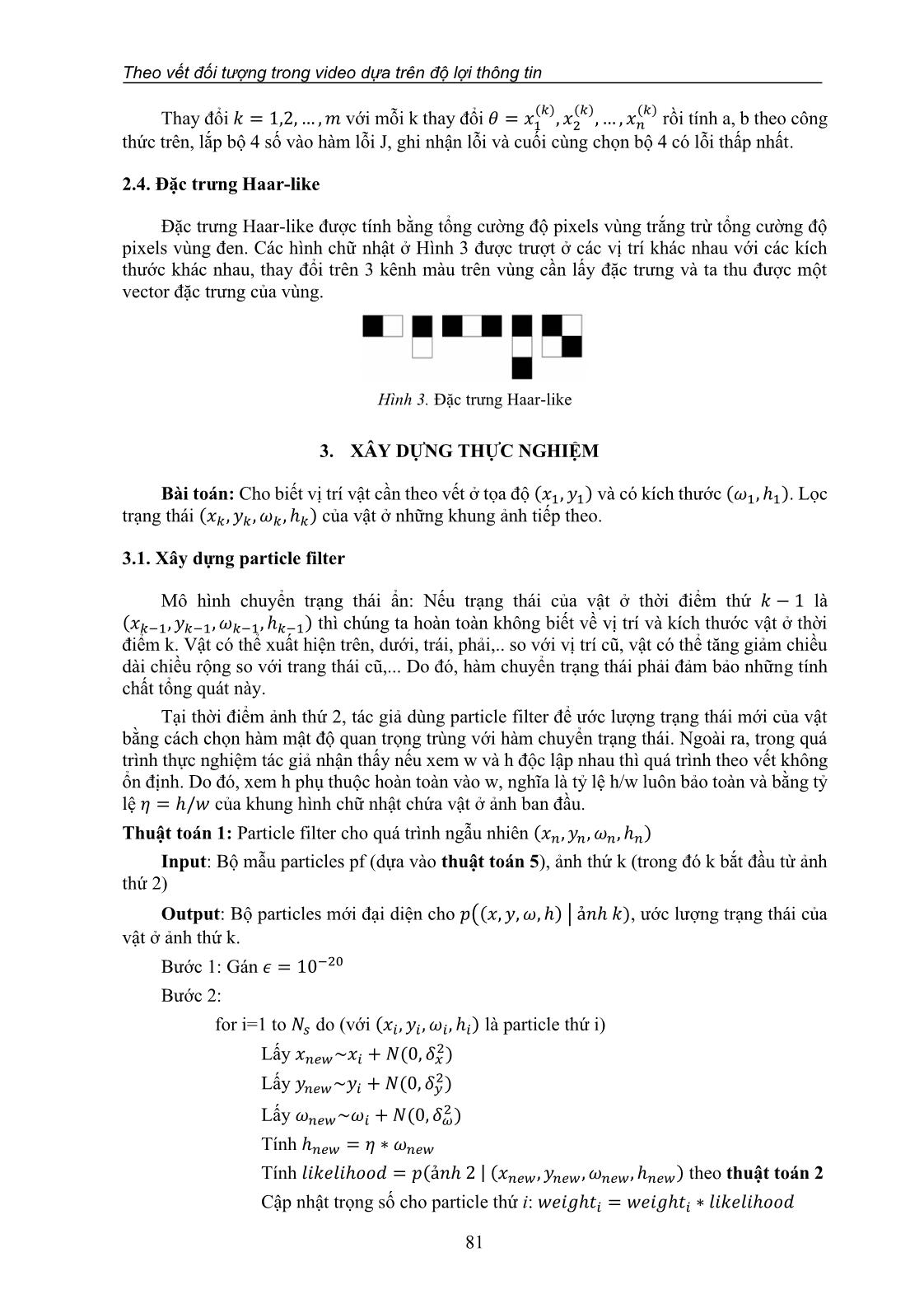

Thuật toán 1: Particle filter cho quá trình ngẫu nhiên (𝑥𝑛, 𝑦𝑛, 𝜔𝑛, ℎ𝑛)

Input: Bộ mẫu particles pf (dựa vào thuật toán 5), ảnh thứ k (trong đó k bắt đầu từ ảnh

thứ 2)

Output: Bộ particles mới đại diện cho 𝑝((𝑥, 𝑦, 𝜔, ℎ) | ả𝑛ℎ 𝑘), ước lượng trạng thái của

vật ở ảnh thứ k.

Bước 1: Gán 𝜖 = 10−20

Bước 2:

for i=1 to 𝑁𝑠 do (với (𝑥𝑖, 𝑦𝑖 , 𝜔𝑖, ℎ𝑖) là particle thứ i)

Lấy 𝑥𝑛𝑒𝑤~𝑥𝑖 + 𝑁(0, 𝛿𝑥

2)

Lấy 𝑦𝑛𝑒𝑤~𝑦𝑖 + 𝑁(0, 𝛿𝑦

2)

Lấy 𝜔𝑛𝑒𝑤~𝜔𝑖 + 𝑁(0, 𝛿𝜔

2 )

Tính ℎ𝑛𝑒𝑤 = 𝜂 ∗ 𝜔𝑛𝑒𝑤

Tính 𝑙𝑖𝑘𝑒𝑙𝑖ℎ𝑜𝑜𝑑 = 𝑝(ả𝑛ℎ 2 | (𝑥𝑛𝑒𝑤 , 𝑦𝑛𝑒𝑤 , 𝜔𝑛𝑒𝑤, ℎ𝑛𝑒𝑤) theo thuật toán 2

Cập nhật trọng số cho particle thứ i: 𝑤𝑒𝑖𝑔ℎ𝑡𝑖 = 𝑤𝑒𝑖𝑔ℎ𝑡𝑖 ∗ 𝑙𝑖𝑘𝑒𝑙𝑖ℎ𝑜𝑜𝑑

Ngô Dương Hà, Trần Như Ý, Lê Hữu Hà, Nguyễn Phương Hạc, Nguyễn Văn Tùng

82

endfor

Bước 3:

Tính tổng 𝑠𝑤 = ∑ 𝑤𝑒𝑖𝑔ℎ𝑡𝑖 + 𝜖

𝑁𝑠

𝑗=1

for i=1 to 𝑁𝑠 do

Chuẩn hóa trọng số 𝑤𝑒𝑖𝑔ℎ𝑡𝑖 =

𝑤𝑒𝑖𝑔ℎ𝑡𝑖+𝜖

𝑠𝑤

endfor

Bước 4: Tính 𝑁𝑒𝑓𝑓 =

1

∑ 𝑤𝑒𝑖𝑔ℎ𝑡𝑗

2𝑁𝑠

𝑗=1

Bước 5:

if 𝑁𝑒𝑓𝑓 < 𝑁𝑠/2 then

{(𝑥𝑖 , 𝑦𝑖 , 𝜔𝑖 , ℎ𝑖), 𝑤𝑒𝑖𝑔ℎ𝑡𝑖}𝑖=1

𝑁𝑠 = 𝑅𝐸𝑆𝐴𝑀𝑃𝐿𝐸({(𝑥𝑖 , 𝑦𝑖 , 𝜔𝑖 , ℎ𝑖), 𝑤𝑒𝑖𝑔ℎ𝑡𝑖}𝑖=1

𝑁𝑠 ) sử

dụng boostrap

endif

Bước 6: Ước lượng trạng thái của vật ở ảnh thứ k bằng việc tính trung bình của bộ

particles mới

𝑇𝑟ạ𝑛𝑔 𝑡ℎá𝑖 ướ𝑐 𝑙ượ𝑛𝑔 = ∑ 𝑤𝑒𝑖𝑔ℎ𝑡𝑖 ∗ 𝑝𝑎𝑟𝑡𝑖𝑐𝑙𝑒[𝑖]

𝑁𝑠

𝑖=1

Thuật toán 2: Tính likelihood của ảnh trên giả thuyết về trạng thái của vật

Input: Ảnh quan sát, giả thuyết (𝑥, 𝑦, 𝜔, ℎ), vector 𝐻𝑂𝐺1của vật ở ảnh thứ nhất, phân

loại mạnh F.

Output: Likelihood 𝑝(ả𝑛ℎ 𝑞𝑢𝑎𝑛 𝑠á𝑡 | 𝑔𝑖ả 𝑡ℎ𝑢𝑦ế𝑡 (𝑥, 𝑦, 𝜔, ℎ))

Bước 1: Trích vùng ảnh trong hình chữ nhật (𝑥, 𝑦, 𝜔, ℎ) ra, ℎ = 𝑐𝑟𝑜𝑝(ả𝑛ℎ, (𝑥, 𝑦, 𝜔, ℎ))

Bước 2: Resize ảnh h về kích thước của vật ở ảnh đầu tiên

Bước 3:

Trích đặc trưng HOG trên h, 𝐻𝑂𝐺2 = 𝑔𝑒𝑡𝐻𝑂𝐺(ℎ)

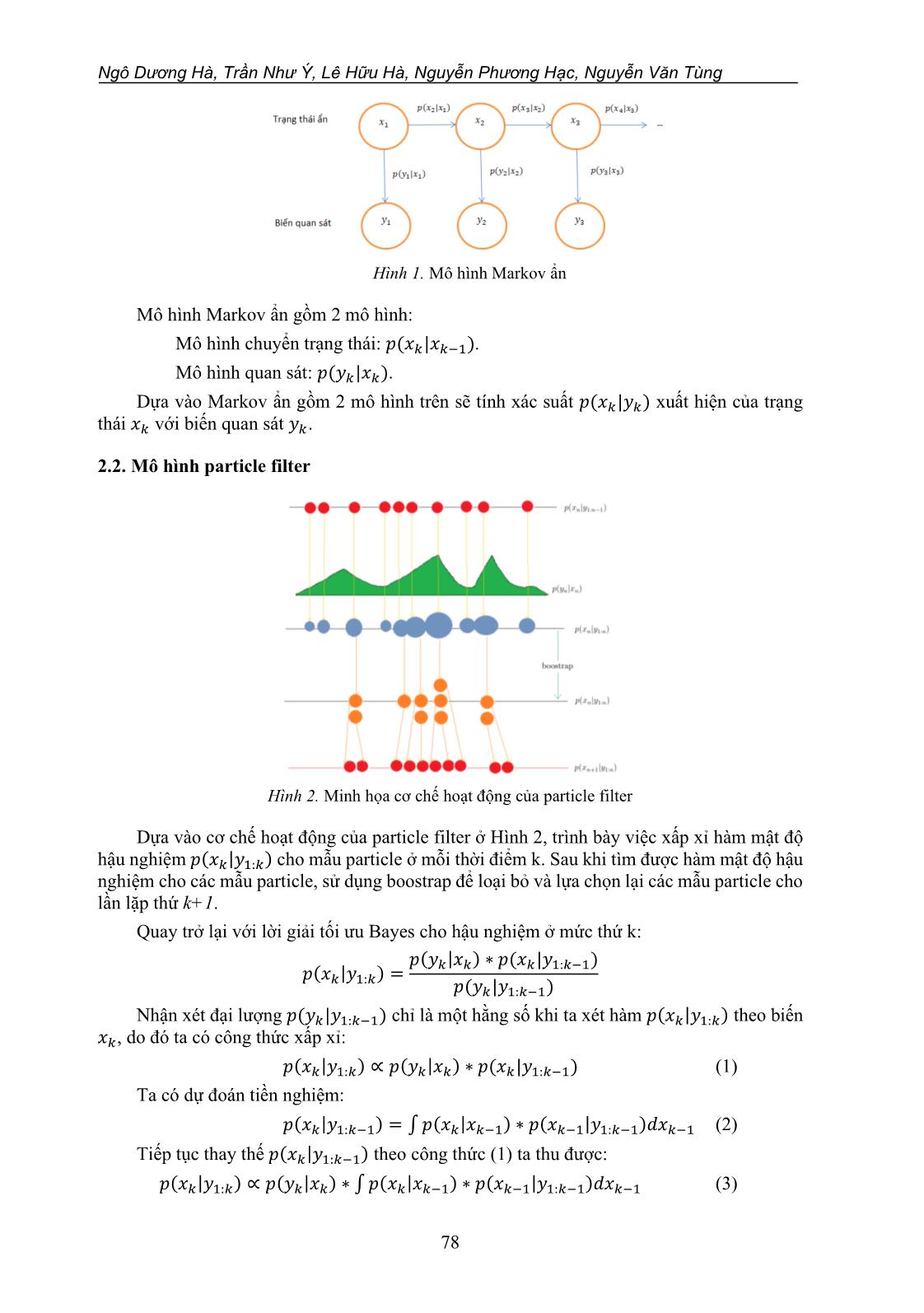

Trích đặc trưng Haar-like trên h, 𝐻𝑎𝑎𝑟2 = 𝑔𝑒𝑡𝐻𝑎𝑎𝑟𝑙𝑖𝑘𝑒(ℎ)

Bước 4: Tính điểm phân loại 𝑐𝑜𝑛𝑓 = 𝐹(𝐻𝑎𝑎𝑟2) theo thuật toán 3

Bước 5: Tính likelihood = exp (α ∗ conf − γ||𝐻𝑂𝐺1 − 𝐻𝑂𝐺2||

2)

Thuật toán 3: Tính điểm phân loại

Input: Phân loại mạnh F là ma trận 4 × 𝑠 (tìm phân loại mạnh dựa vào thuật toán 4),

vector đặc trưng Haar-like x của vùng cần tính điểm

Output: Điểm phân loại conf

Bước 1: Gán điểm 𝑐𝑜𝑛𝑓 = 0

Bước 2:

for i=1 to s do

Lấy 𝑎, 𝑏, 𝜃, 𝑘 là phân loại yếu thứ i

Cập nhật 𝑐𝑜𝑛𝑓 = 𝑐𝑜𝑛𝑓 + 𝑎 × (𝑥[𝑘] > 𝜃) + 𝑏

endfor

Thuật toán 4: Gentle Adaboost

Theo vết đối tượng trong video dựa trên độ lợi thông tin

83

Input: Tập huấn luyện (𝑥1, 𝑦1), (𝑥2, 𝑦2), , (𝑥𝑁, 𝑦𝑁) với 𝑦𝑖 ∈ {1, −1} là nhãn của 𝑥𝑖

Output: Hàm phân loại mạnh F

Bước 1: Khởi tạo hệ số 𝜔1 = 𝜔2 = ⋯ = 𝜔𝑁 =

1

𝑁

cho tập huấn luyện

Bước 2:

for t=1 to s do

for j=1 to m do

Huấn luyện phân loại yếu ℎ𝑗, tức là tính (𝑎, 𝑘, 𝜃, 𝑏) theo công thức

endfor

Chọn phân loại yếu có lỗi thấp nhất, đặt là 𝑓𝑡

Cập nhật phân loại mạnh 𝐹(𝑥) = 𝐹(𝑥) + 𝑓𝑡(𝑥)

Cập nhật trọng số 𝜔𝑖 = 𝜔𝑖 × exp (−𝑦𝑖𝑓𝑡(𝑥𝑖))

endfor

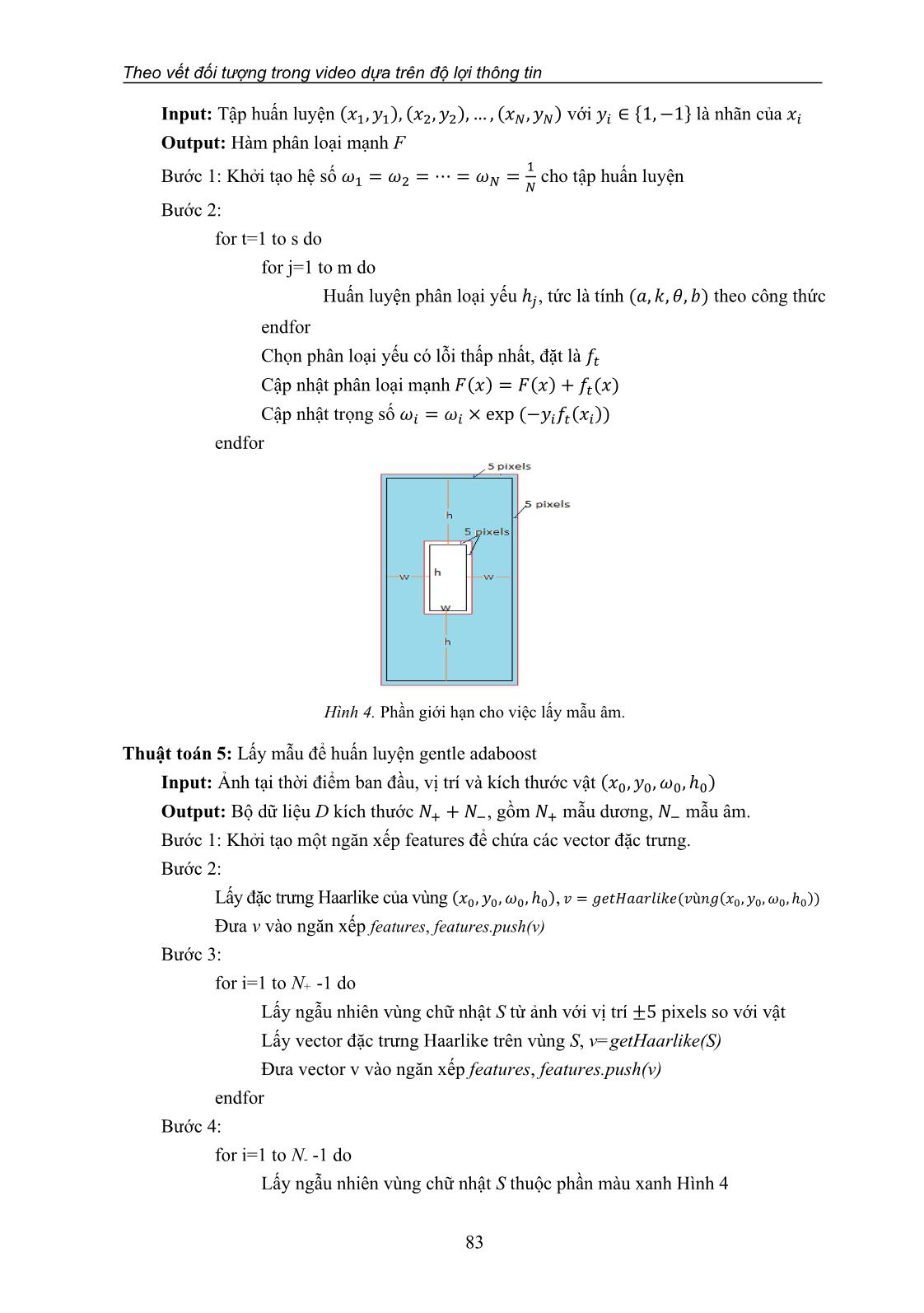

Hình 4. Phần giới hạn cho việc lấy mẫu âm.

Thuật toán 5: Lấy mẫu để huấn luyện gentle adaboost

Input: Ảnh tại thời điểm ban đầu, vị trí và kích thước vật (𝑥0, 𝑦0, 𝜔0, ℎ0)

Output: Bộ dữ liệu D kích thước 𝑁+ + 𝑁−, gồm 𝑁+ mẫu dương, 𝑁− mẫu âm.

Bước 1: Khởi tạo một ngăn xếp features để chứa các vector đặc trưng.

Bước 2:

Lấy đặc trưng Haarlike của vùng (𝑥0, 𝑦0, 𝜔0, ℎ0), 𝑣 = 𝑔𝑒𝑡𝐻𝑎𝑎𝑟𝑙𝑖𝑘𝑒(𝑣ù𝑛𝑔(𝑥0, 𝑦0, 𝜔0, ℎ0))

Đưa v vào ngăn xếp features, features.push(v)

Bước 3:

for i=1 to N+ -1 do

Lấy ngẫu nhiên vùng chữ nhật S từ ảnh với vị trí ±5 pixels so với vật

Lấy vector đặc trưng Haarlike trên vùng S, v=getHaarlike(S)

Đưa vector v vào ngăn xếp features, features.push(v)

endfor

Bước 4:

for i=1 to N- -1 do

Lấy ngẫu nhiên vùng chữ nhật S thuộc phần màu xanh Hình 4

Ngô Dương Hà, Trần Như Ý, Lê Hữu Hà, Nguyễn Phương Hạc, Nguyễn Văn Tùng

84

Lấy vector đặc trưng Haarlike trên vùng S, v=getHaarlike(S)

Đưa vector v vào ngăn xếp features, features.push(v)

endfor

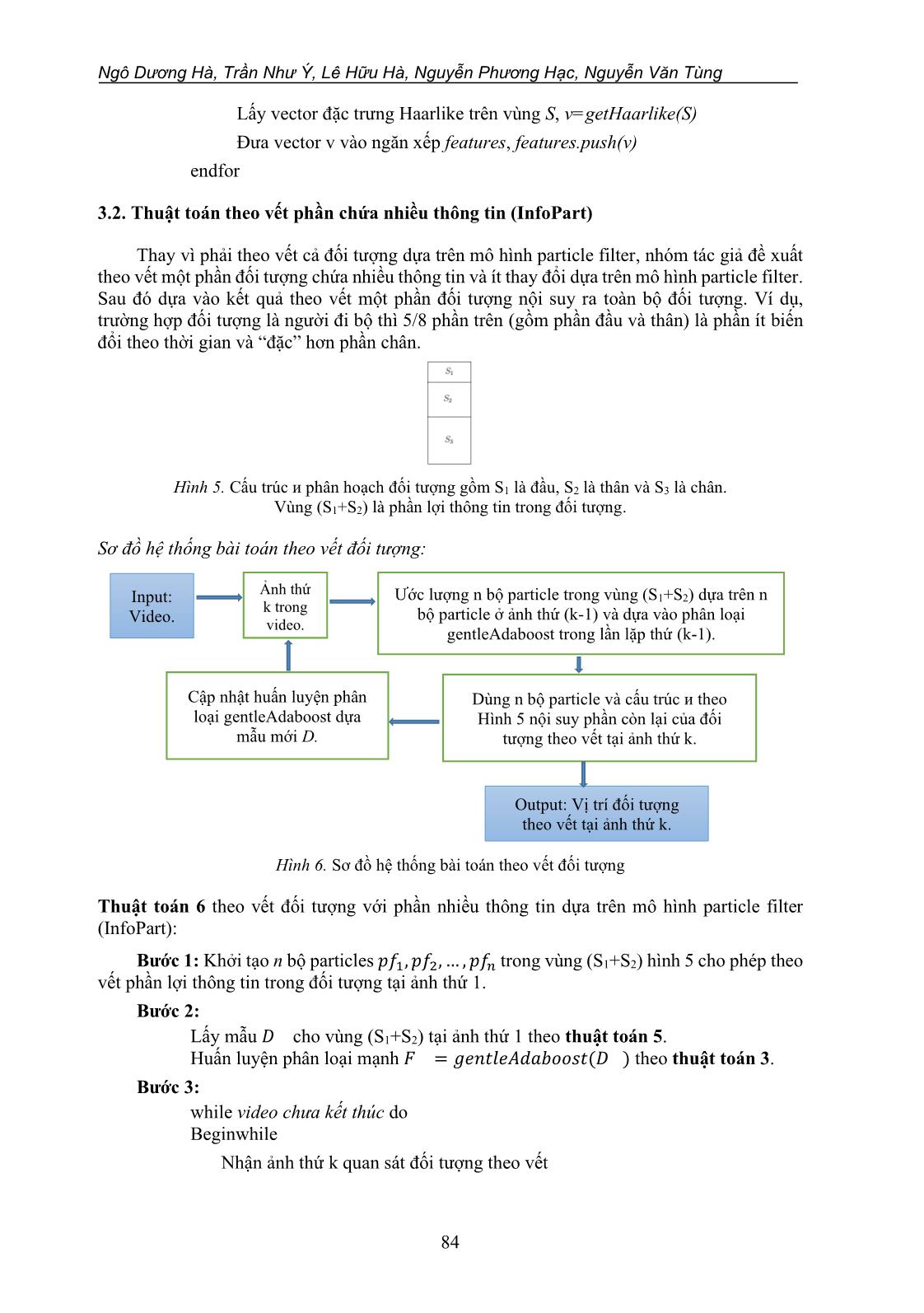

3.2. Thuật toán theo vết phần chứa nhiều thông tin (InfoPart)

Thay vì phải theo vết cả đối tượng dựa trên mô hình particle filter, nhóm tác giả đề xuất

theo vết một phần đối tượng chứa nhiều thông tin và ít thay đổi dựa trên mô hình particle filter.

Sau đó dựa vào kết quả theo vết một phần đối tượng nội suy ra toàn bộ đối tượng. Ví dụ,

trường hợp đối tượng là người đi bộ thì 5/8 phần trên (gồm phần đầu và thân) là phần ít biến

đổi theo thời gian và “đặc” hơn phần chân.

Hình 5. Cấu trúc ᴎ phân hoạch đối tượng gồm S1 là đầu, S2 là thân và S3 là chân.

Vùng (S1+S2) là phần lợi thông tin trong đối tượng.

Sơ đồ hệ thống bài toán theo vết đối tượng:

Hình 6. Sơ đồ hệ thống bài toán theo vết đối tượng

Thuật toán 6 theo vết đối tượng với phần nhiều thông tin dựa trên mô hình particle filter

(InfoPart):

Bước 1: Khởi tạo n bộ particles 𝑝𝑓1, 𝑝𝑓2, , 𝑝𝑓𝑛 trong vùng (S1+S2) hình 5 cho phép theo

vết phần lợi thông tin trong đối tượng tại ảnh thứ 1.

Bước 2:

Lấy mẫu 𝐷 cho vùng (S1+S2) tại ảnh thứ 1 theo thuật toán 5.

Huấn luyện phân loại mạnh 𝐹 = 𝑔𝑒𝑛𝑡𝑙𝑒𝐴𝑑𝑎𝑏𝑜𝑜𝑠𝑡(𝐷 ) theo thuật toán 3.

Bước 3:

while video chưa kết thúc do

Beginwhile

Nhận ảnh thứ k quan sát đối tượng theo vết

Ảnh thứ

k trong

video.

Ước lượng n bộ particle trong vùng (S1+S2) dựa trên n

bộ particle ở ảnh thứ (k-1) và dựa vào phân loại

gentleAdaboost trong lần lặp thứ (k-1).

Input:

Video.

Dùng n bộ particle và cấu trúc ᴎ theo

Hình 5 nội suy phần còn lại của đối

tượng theo vết tại ảnh thứ k.

Cập nhật huấn luyện phân

loại gentleAdaboost dựa

mẫu mới D.

Output: Vị trí đối tượng

theo vết tại ảnh thứ k.

Theo vết đối tượng trong video dựa trên độ lợi thông tin

85

Dùng n bộ particle ước lượng trạng thái vùng (S1+S2) tại ảnh thứ k theo thuật

toán 1

Dùng phần lợi thông tin vùng (S1+S2) và cấu trúc ᴎ theo Hình 5 nội suy phần

còn lại của đối tượng theo vết tại ảnh thứ k (Nghĩa là ước lượng trạng thái

của đối tượng theo vết ở ảnh thứ k dựa trên n bộ particle).

Lấy mẫu mới 𝐷∗ dựa trên phần lợi thông tin trong đối tượng theo vết tại ảnh

thứ k.

Cập nhật phân loại mạnh 𝐹.

endwhile

4. KẾT QUẢ THỰC NGHIỆM

Môi trường cài đặt: Tác giả thực nghiệm trên máy tính sử dụng hệ điều hành Windows

10 Pro bản 64 bit, RAM 8 GB, Chip Intel Core (TM) 5i-3210M CPU @ 2.5GHz. Ngôn ngữ

lập trình Matlab phiên bản R2016a.

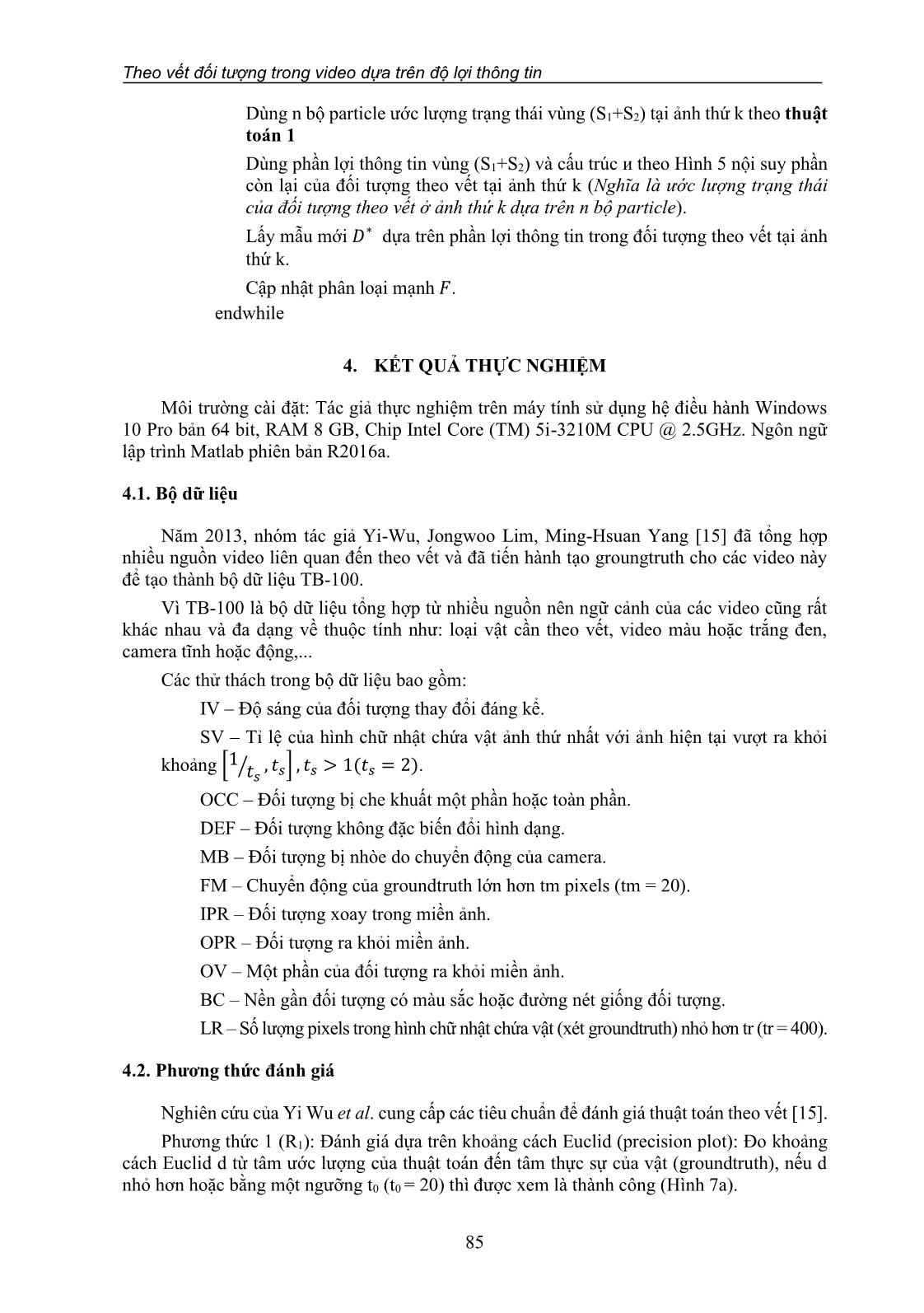

4.1. Bộ dữ liệu

Năm 2013, nhóm tác giả Yi-Wu, Jongwoo Lim, Ming-Hsuan Yang [15] đã tổng hợp

nhiều nguồn video liên quan đến theo vết và đã tiến hành tạo groungtruth cho các video này

để tạo thành bộ dữ liệu TB-100.

Vì TB-100 là bộ dữ liệu tổng hợp từ nhiều nguồn nên ngữ cảnh của các video cũng rất

khác nhau và đa dạng về thuộc tính như: loại vật cần theo vết, video màu hoặc trắng đen,

camera tĩnh hoặc động,...

Các thử thách trong bộ dữ liệu bao gồm:

IV – Độ sáng của đối tượng thay đổi đáng kể.

SV – Tỉ lệ của hình chữ nhật chứa vật ảnh thứ nhất với ảnh hiện tại vượt ra khỏi

khoảng [1 𝑡𝑠⁄

, 𝑡𝑠] , 𝑡𝑠 > 1(𝑡𝑠 = 2).

OCC – Đối tượng bị che khuất một phần hoặc toàn phần.

DEF – Đối tượng không đặc biến đổi hình dạng.

MB – Đối tượng bị nhòe do chuyển động của camera.

FM – Chuyển động của groundtruth lớn hơn tm pixels (tm = 20).

IPR – Đối tượng xoay trong miền ảnh.

OPR – Đối tượng ra khỏi miền ảnh.

OV – Một phần của đối tượng ra khỏi miền ảnh.

BC – Nền gần đối tượng có màu sắc hoặc đường nét giống đối tượng.

LR – Số lượng pixels trong hình chữ nhật chứa vật (xét groundtruth) nhỏ hơn tr (tr = 400).

4.2. Phương thức đánh giá

Nghiên cứu của Yi Wu et al. cung cấp các tiêu chuẩn để đánh giá thuật toán theo vết [15].

Phương thức 1 (R1): Đánh giá dựa trên khoảng cách Euclid (precision plot): Đo khoảng

cách Euclid d từ tâm ước lượng của thuật toán đến tâm thực sự của vật (groundtruth), nếu d

nhỏ hơn hoặc bằng một ngưỡng t0 (t0 = 20) thì được xem là thành công (Hình 7a).

Ngô Dương Hà, Trần Như Ý, Lê Hữu Hà, Nguyễn Phương Hạc, Nguyễn Văn Tùng

86

Phương thức 2 (R2): Đánh giá dựa trên mức độ trùng nhau. Số điểm trùng lấp được định

nghĩa 𝑆 =

|𝑟𝑡∩𝑟𝑎|

|𝑟𝑡∪𝑟𝑎|

, trong đó: 𝑟𝑡 là hình chữ nhật bao vật do thuật toán ước lượng và 𝑟𝑎 là hình

chữ nhật groundtruth (Hình 7b).

Tính tỷ lệ 𝑅1, 𝑅2 =

𝑠ố ả𝑛ℎ 𝑡ℎà𝑛ℎ 𝑐ô𝑛𝑔

𝑡ổ𝑛𝑔 𝑠ố ả𝑛ℎ

Hình 7. (a) Đo khoảng cách Euclid; (b) đo mức độ trùng nhau

4.3. Kết quả đánh giá

Kết quả theo vết người với camera không dao động nhiều và bảo toàn tương đối các tỷ

lệ trên cơ thể người và người không quá nhỏ. Tác giả sử dụng thuật toán InfoPart so sánh với

thuật toán GradNet [16].

Bảng 1. Kết quả thuật toán GradNet và InfoPart

Video Thuộc tính

GradNet % InfoPart %

R1 R2 R1 R2

Crossing SV, DEF, FM, OPR, BC 100 100 100 98,33

Dancer SV, DEF, IPR, OPR 92,44 98,22 95,11 88,89

Dancer2 DEF 100 100 77,33 59,01

David3 OCC, DEF, OPR, BC 100 100 73,02 81,35

Human8 IV, SV, DEF 8,59 7,03 100 89,06

Walking SV, OCC, DEF 100 99,27 100 98,54

Walking2 SV, OCC, LR 100 100 100 100

85,86 86,36 92,21 87,88

5. KẾT LUẬN VÀ HƯỚNG PHÁT TRIỂN

Thuật toán InfoPart lấy phần có lợi thông tin 5/8 đối tượng người (gồm đầu và thân) cần

theo vết cho kết quả tốt hơn thuật toán GradNet. Cụ thể, cho thấy độ chính xác trung bình

của thuật toán InfoPart (R1 = 92,21%, R2 = 87,88%) lớn hơn so với thuật toán GradNet

(R1 = 85,86%, R2 = 86,36%).

Ngoài ra, theo vết phần có nhiều thông tin rồi nội suy phần còn lại sẽ giảm thời gian tính

toán so với thuật toán cơ sở particle filter ban đầu theo vết trên toàn bộ đối tượng.

Đối với lớp video theo vết người, camera tương đối ổn định và phép quay góc bảo toàn

tương đối tỷ lệ cơ thể người, tác giả theo vết phần có nhiều thông tin nhất rồi suy ra cả cơ thể.

Kết quả thực nghiệm của các thuật toán nêu trên cho từng video là chênh lệch nhau rất lớn,

cao nhất là 100% và thấp nhất là 59%. Kết quả này cũng dễ hiểu vì bộ dữ liệu TB-100 là tổng

Theo vết đối tượng trong video dựa trên độ lợi thông tin

87

hợp của rất nhiều bộ dữ liệu khác, rất đa dạng và nhiều thử thách. Nhìn chung, kết quả đạt ở

mức tốt.

Hướng phát triển là thay đổi mô hình quan sát. Nhóm tác giả nhận thấy quá trình huấn

luyện gentle adaboost rất tốn thời gian và khiến cho hệ thống chưa thể hoạt động theo thời

gian thực được. Các thuật toán sử dụng lớp bộ lọc tương quan lại có ưu điểm là tốc độ xử lý

rất nhanh và chính xác, nếu tích hợp được lớp bộ lọc tương quan này vào mô hình quan sát thì

sẽ rút ngắn đáng kể thời gian thực thi.

Lời cảm ơn: Nghiên cứu này do Trường Đại học Công nghiệp Thực phẩm TP.HCM bảo trợ

và cấp kinh phí theo Hợp đồng số 50/HĐ-DCT ngày 03 tháng 09 năm 2019.

TÀI LIỆU THAM KHẢO

1. David S. Bolme, Bruce A. Draper, J. Ross Beveridge - Average of synthetic exact

filters, IEEE Conference on Computer Vision and Pattern Recognition (2009).

2. Joao F. Henriques, Rui Caseiro, Pedro Martins, and Jorge Batista - Exploiting the

circulant structure of tracking-by-detection with kernels, European Conference on

Computer Vision (2012) 702-715.

3. Joao F. Henriques, Rui Caseiro, Pedro Martins, and Jorge Batista - High-speed

tracking with kernelized correlation filters, IEEE Transactions on Pattern Analysis and

Machine Intelligence (2015) 583-596.

4. Divid S.Bolme, J.Ross Beveridge, Bruce A. Draper, Yui Man Lui - Visual object

tracking using adaptive correlation filters, IEEE Computer Society Conference on

Computer Vision and Pattern Regconition (2010) 2544-2550.

5. Shai Avidan - Ensemble tracking, IEEE Transactions on Pattern Analysis and

Machine Intelligence (2007).

6. Freund Y. - An adaptive version of the boost by majority algorithm, Machine Learning

43 (2001) 293-318.

7. Zhe Chen - Bayesian filtering: from kalman filters to particle filters, and beyond,

Statistics: A Journal of Theoretical and Applied Statistics (2003).

8. Arnaud Doucet, Adam M. Johansen - A tutorial on particle filtering and smoothing:

Fifteen years later (2008).

9. Daniel Jurafsky, James H. Martin - Chapter 9: Hidden Markov models, Speech and

Language Processing (2017).

10. Dominik A. Klein, Dirk Schulz, Simone Frintrop, and Armin B. Cremers - Adaptive

real-time video-tracking for arbitrary objects, IEEE/RSJ International Conference on

Intelligent Robots and Systems (2010) 772-777.

11. Perez P., Hue C., Varmaak J., Gangnet M. - Color-based probabilistic tracking,

European Conference on Computer Vision (2002) 661-675.

12. Changjiang Yang, Ramani Duraiswami, Larry Davis - Fast multiple object tracking

via a hierarchical particle filter, 10th IEEE International Conference on Computer

Vision (2005) 212-219.

13. Olov Samualssonn - Video tracking algorithm for unmanned aerial vehicle

Surveillance, Stockholm - Sweden (2012).

14. Sanjeev Arulampalam, Simson Maskell, Neil Gordon, Tim Clapp - A tutorial on

particle filters for online no-linear/non-gaussian bayesian tracking, IEEE Transactions

on Signal Processing 50 (2) (2002) 174-188.

Ngô Dương Hà, Trần Như Ý, Lê Hữu Hà, Nguyễn Phương Hạc, Nguyễn Văn Tùng

88

15. Yi Wu, Jongwoo Lim, Ming-Hsuan Yang - Online object tracking: A benchmark,

Computer Vision and Pattern Recognition (2013).

16. Peixia Li, Boyu Chen, Wanli Ouyang, Dong Wang, Xiaoyun Yang, Huchuan Lu -

GradNet: Gradient-guided network for visual object tracking, IEEE International

Conference on Computer Vision (ICCV) (2019).

ABSTRACT

TRACKING MOVING OBJECTS IN VIDEO BASED ON BENEFIT PART

Ngo Duong Ha, Tran Nhu Y, Le Huu Ha,

Nguyen Phuong Hac, Nguyen Van Tung*

Ho Chi Minh City University of Food Industry

*Email: tungnv@hufi.edu.vn

Tracking object in video is important problem of computer vision. Tracking the

movement of objects that can be used in security systems, automatic observation, integrated

into robots unmanned aerial vehicles of the military, etc. This paper presents an approach that

describes the problem in terms of filtering a hidden Markov model using particle filters to filter

the random process and combining the computation of confidence scores from gentle

adaboost. We suggest tracking the more informative parts (head, body) and omitting the foot

part which is the more oscillating part. An InfoPart algorithm is proposes to track the benefit

part (head, body) without leg that is more oscillatory. Experimental results show that the

average accuracy of InfoPart algorithm is greater than GradNet algorithm.

Keywords: Hidden Markov model, gentle adaboost, particle filter, Haar like.

File đính kèm:

theo_vet_doi_tuong_trong_video_dua_tren_do_loi_thong_tin.pdf

theo_vet_doi_tuong_trong_video_dua_tren_do_loi_thong_tin.pdf