Nhận dạng vị trí tải trên cầu trục container bằng camera

Tóm tắt

Trong nghiên cứu này, nhóm tác giả đề xuất một giải thuật xử lý ảnh để xác định độ dài dây của cầu trục container

(khoảng cách từ hệ camera đến vị trí ngàm kẹp container) và góc lắc của ngàm kẹp container làm cơ sở cho việc thiết

kế thuật toán điều khiển chống lắc cho cầu trục container. Giải thuật xử lý ảnh bao gồm các bước chính: chuyển đổi từ

không gian màu BGR sang không gian màu HSV, nhị phân ảnh nhằm trích xuất vùng đối tượng đã được đánh dấu

(marker). Tiếp theo, kỹ thuật dò biên Canny và xác định đường bao được áp dụng để xác định vị trí của các điểm được

đánh dấu trên ngàm kẹp container. Cuối cùng, tâm của các điểm đánh dấu được xác định và được sử dụng để tính toán

khoảng cách từ hệ camera đến vị trí ngàm kẹp container. Độ chính xác của giải thuật xác định khoảng cách là 99,79%,

đáp ứng được yêu cầu đo đạc cho điều khiển.

Từ khóa: Xử lý ảnh, độ dài dây, cầu trục container, điểm định vị, góc lắc.

Abstract

In this study, the authors proposed an image processing algorithm to detect (measure) the rope length of container

crane (distance from camera system to container spreader) and sway angle of the spearder (container). This

measurement will be the main input to design the anti-sway control system for container cranes. The image processing

algorithm includes the main steps: converting from BGR color space to HSV color space, then, binary image is used to

extract the marker area. Next, the Canny boundary detection technique is applied to determine the boundary of the

markers in the container spreader. The center location of each marker is determined and used to calculate the distance

from the camera system to the container spreader is calculated. The rope length accuracy by the image processing

algorithm is 99,79%. It is satisfied for crane control purpose.

Trang 1

Trang 2

Trang 3

Trang 4

Trang 5

Trang 6

Trang 7

Tóm tắt nội dung tài liệu: Nhận dạng vị trí tải trên cầu trục container bằng camera

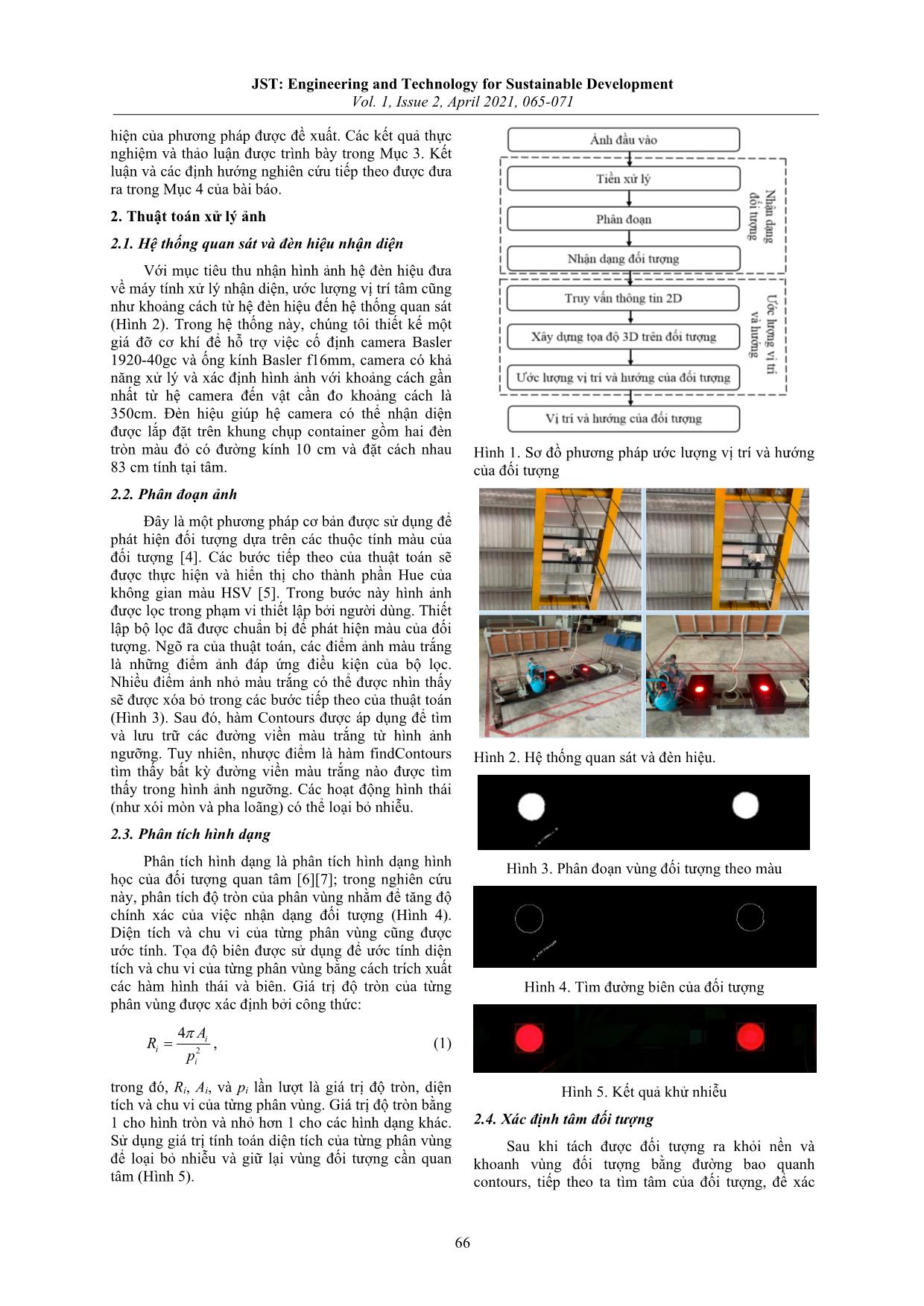

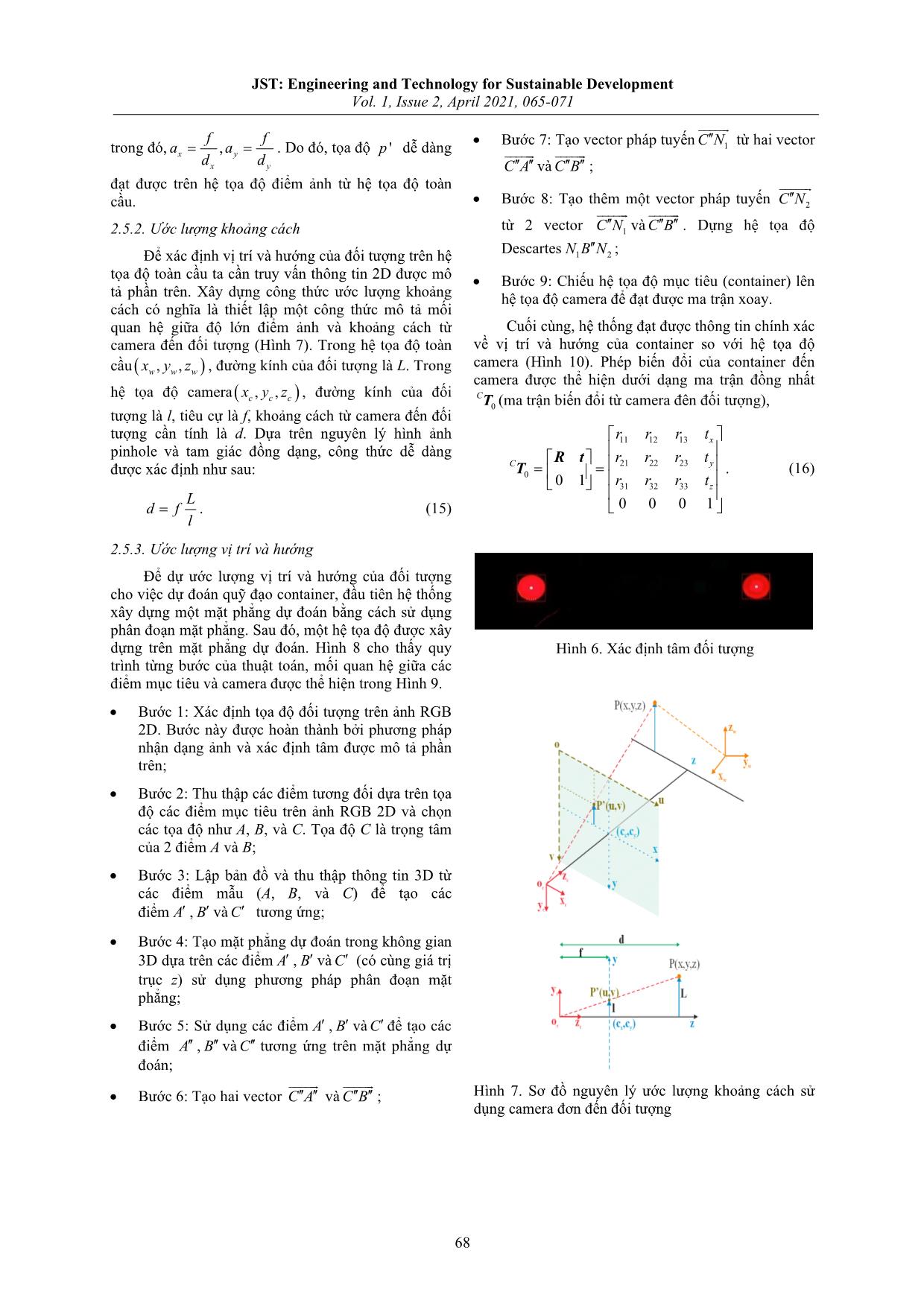

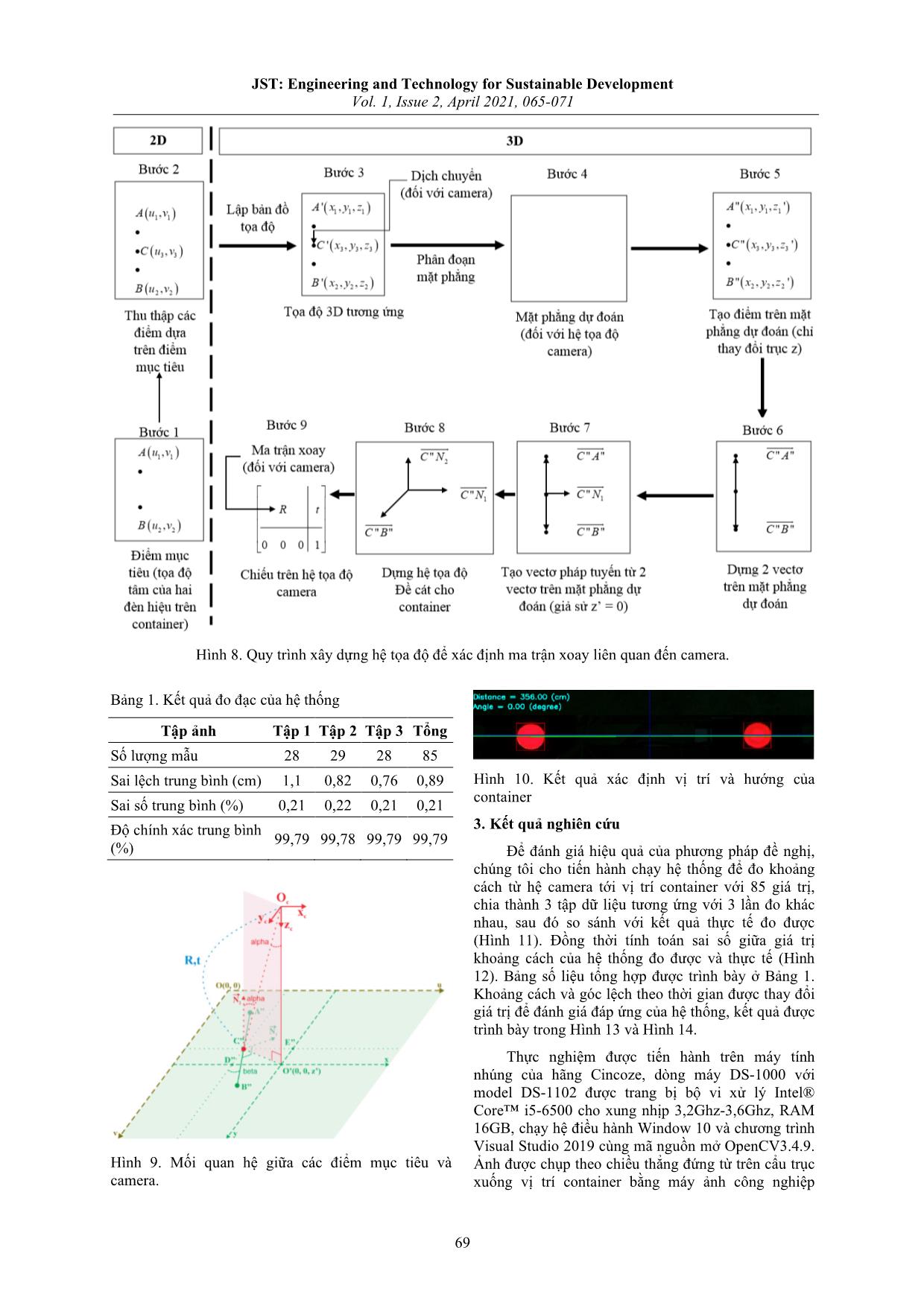

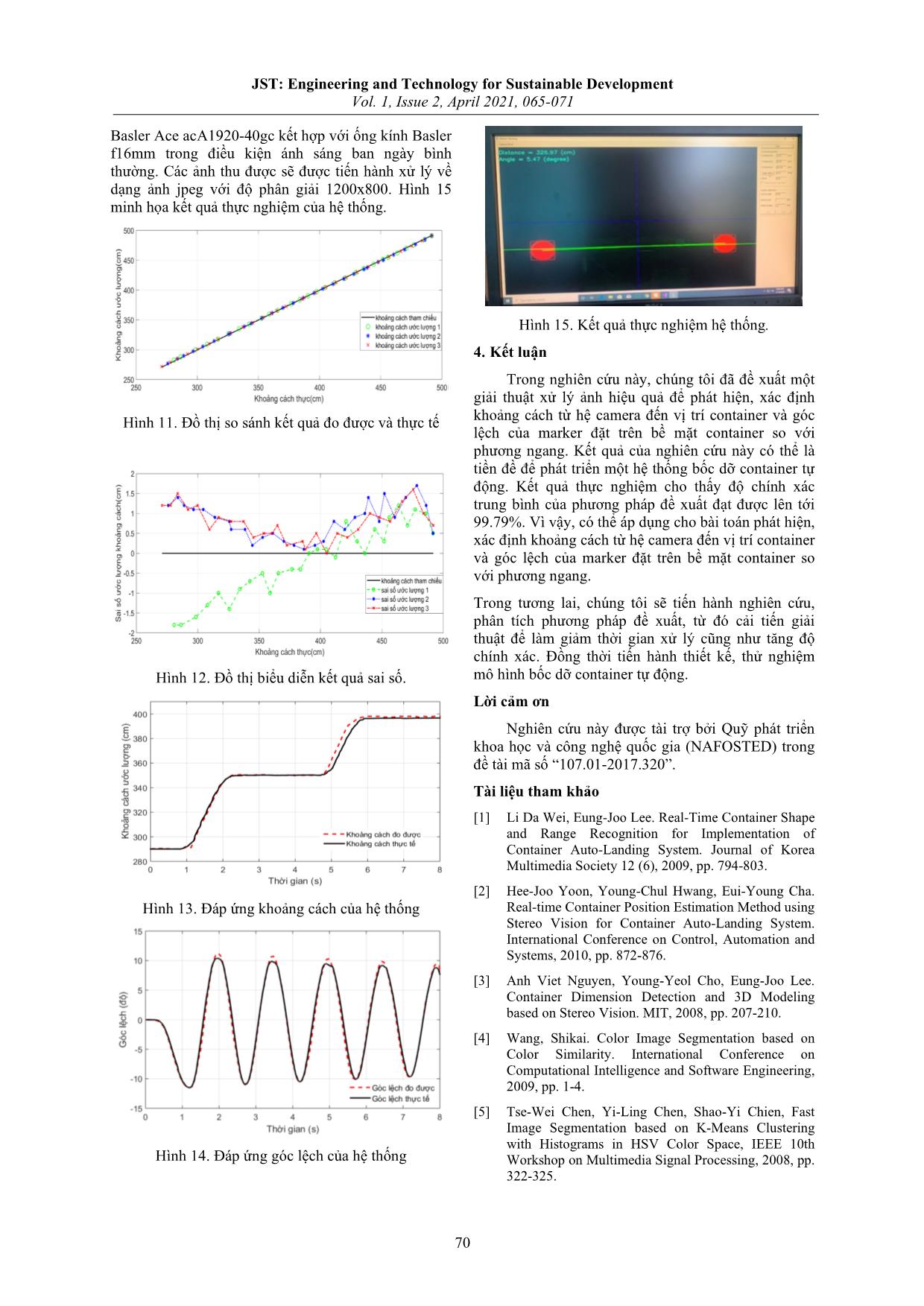

JST: Engineering and Technology for Sustainable Development Vol. 1, Issue 2, April 2021, 065-071 65 Nhận dạng vị trí tải trên cầu trục container bằng camera Load Position Detection of Container Crane Using Camera Ngô Quang Hiếu*, Lê Văn Lẻ, Nguyễn Hữu Quang, Trương Quốc Bảo, Nguyễn Hữu Cường Đại học Cần Thơ, Cần Thơ, Việt Nam *Email: nqhieu@ctu.edu.vn Tóm tắt Trong nghiên cứu này, nhóm tác giả đề xuất một giải thuật xử lý ảnh để xác định độ dài dây của cầu trục container (khoảng cách từ hệ camera đến vị trí ngàm kẹp container) và góc lắc của ngàm kẹp container làm cơ sở cho việc thiết kế thuật toán điều khiển chống lắc cho cầu trục container. Giải thuật xử lý ảnh bao gồm các bước chính: chuyển đổi từ không gian màu BGR sang không gian màu HSV, nhị phân ảnh nhằm trích xuất vùng đối tượng đã được đánh dấu (marker). Tiếp theo, kỹ thuật dò biên Canny và xác định đường bao được áp dụng để xác định vị trí của các điểm được đánh dấu trên ngàm kẹp container. Cuối cùng, tâm của các điểm đánh dấu được xác định và được sử dụng để tính toán khoảng cách từ hệ camera đến vị trí ngàm kẹp container. Độ chính xác của giải thuật xác định khoảng cách là 99,79%, đáp ứng được yêu cầu đo đạc cho điều khiển. Từ khóa: Xử lý ảnh, độ dài dây, cầu trục container, điểm định vị, góc lắc. Abstract In this study, the authors proposed an image processing algorithm to detect (measure) the rope length of container crane (distance from camera system to container spreader) and sway angle of the spearder (container). This measurement will be the main input to design the anti-sway control system for container cranes. The image processing algorithm includes the main steps: converting from BGR color space to HSV color space, then, binary image is used to extract the marker area. Next, the Canny boundary detection technique is applied to determine the boundary of the markers in the container spreader. The center location of each marker is determined and used to calculate the distance from the camera system to the container spreader is calculated. The rope length accuracy by the image processing algorithm is 99,79%. It is satisfied for crane control purpose. Keywords: Image processing, rope length detection, container crane, marker, sway angle. 1. Giới thiệu1 Tại các cảng biển, việc rút ngắn thời gian chờ tàu và bốc dỡ hàng hóa đóng vai trò quan trọng nhằm tăng hiệu xuất làm việc và tiết giảm chi phí cho doanh nghiệp. Tuy nhiên việc bốc dỡ lại phụ thuộc hoàn toàn vào kinh nghiệm của người lái cầu trục, do đó một người lái cầu trục cần kinh nghiệm ít nhất 5 năm để đạt năng suất bốc dỡ trung bình 30-35 container/giờ. Vấn đề khó khăn đặt ra cho người lái cầu trục đó là tầm quan sát bị hạn chế do ảnh hưởng bởi khoảng cách, việc bốc dỡ một container ở khoảng cách khoảng 30m là không hề dễ dàng. Việc nghiên cứu một hệ thống nhằm hỗ trợ người lái cầu trục xác định vị trí của tải là hết sức cần thiết và có giá trị thực tiễn cao. Hệ thống định vị, xác định khoảng cách từ hệ camera đến vị trí container cũng như tính toán góc lắc của container trong quá trình chuyển động đóng vai trò quan trọng trong việc hỗ trợ người lái cầu trục điều khiển bốc dỡ container. Các hệ thống như vậy đang được phát triển và ứng dụng trong ngành công nghiệp ISSN: 2734-9381 https://doi.org/10.51316/jst.149.etsd.2021.1.2.11 Received: August 12, 2020; accepted: November 18, 2020 tự động hóa, thông minh ở một số quốc gia phát triển trên thế giới với nhiều công trình nghiên cứu liên quan. Tuy nhiên, các nghiên cứu như vậy ở Việt Nam là rất hạn chế. Các nghiên cứu chỉ dừng lại ở đề xuất sử dụng một hệ gồm nhiều camera khác nhau để thu nhận thông tin ảnh độ sâu của đối tượng cần quan tâm, từ đó xác định vị trí cũng như kích thước container [1][2][3]. Phần lớn các nghiên cứu này chỉ mới ở giai đoạn mô phỏng, chưa xây dựng được một hệ thống áp dụng thực tế. Riêng ở nước ta, các nghiên cứu áp dụng những ứng dụng này vẫn còn chưa phổ biến, chủ yếu là ở kinh nghiệm quan sát của người lái cầu trục, vì vậy nghiên cứu này là rất cần thiết và có ý nghĩa thực tiễn. Bài báo đề xuất một giải thuật xử lý ảnh mới để định vị, xác định khoảng cách từ hệ camera đến vị trị container và ước lượng góc lệch của hệ container so với phương ngang sử dụng các kỹ thuật xử lý ảnh. Đầu tiên, ảnh thu nhận được từ hệ thống sẽ được chuyển đổi từ không gian màu RGB sang HSV để xử lý. Tiếp theo, tìm biên đối tượng với bộ lọc Canny, tính diện tích đường bao của đối tượng để loại bỏ những vùng đối tượng nhiễu và tính khoảng cách từ hệ camera đến tâm đối tượng. Quy trình xử lý tổng quát của phương pháp được trình bày như trong Hình 1. Mục tiếp theo của bài viết mô tả chi tiết nội dung thực JST: Engineering and Technology for Sustainable Development Vol. 1, Issue 2, April 2021, 065-071 66 hiện của phương pháp được đề xuất. Các kết quả thực nghiệm và thảo luận được trình bày trong Mục 3. Kết luận và các định hướng nghiên cứu tiếp theo được đưa ra trong Mục 4 của bài báo. 2. Thuật toán xử lý ảnh 2.1. Hệ thống quan sát và đèn hiệu nhận diện Với mục tiêu thu nhận hình ảnh hệ đèn hiệu đưa về máy tính xử lý nhận diện, ước lượng vị trí tâm cũng như khoảng cách từ hệ đèn hiệu đến hệ thống quan sát (Hình 2). Trong hệ thống này, chúng tôi thiết kế một giá đỡ cơ khí để hỗ trợ việc cố định camera Basler 1920-40gc và ống kính Basler f16mm, camera có khả năng xử lý và xác định hình ảnh với khoảng cách gần nhất từ hệ camera đến vật cần đo khoảng cách là 350cm. Đèn hiệu giúp hệ camera có thể nhận diện được lắp đặt trên khung chụp container gồm hai đèn tròn màu đỏ có đường kính 10 cm và đặt cách nhau 83 cm tính tại tâm. 2.2. Phân đoạn ảnh Đây là một phương pháp cơ bản được sử dụng để phát hiện đối tượng dựa trên các thuộc tính màu của đối tượng [4]. Các bước tiếp theo của thuật toán sẽ được thực hiện và hiển thị cho thành phần Hue của không gian màu HSV [5]. Trong bước này hình ảnh được lọc trong phạm vi thiết lập bởi người dùng. Thiết lập bộ lọc đã được chuẩn bị để phát hiện màu của đối tượng. Ngõ ra của thuật toán, các điểm ảnh màu trắng là những điểm ảnh đáp ứng điều kiện của bộ lọc. Nhiều điểm ảnh nhỏ màu trắng có thể được nhìn thấy sẽ được xóa bỏ trong các bước tiếp theo của thuật toán (Hình 3). Sau đó, hàm Contours được áp dụng để tìm và lưu trữ các đường viền màu trắng từ hình ảnh ngưỡng. Tuy nhiên, nhược điểm là hàm findContours tìm thấy bất kỳ đường viền màu trắng nào được tìm thấy trong hình ảnh ngưỡng. Các hoạt động hình thái (như xói mòn và pha loãng) có thể loại bỏ nhiễu. 2.3. Phân tích hình dạng Phân tích hình dạng là phân tích hình dạng hình học của đối tượng quan tâm [6][7]; trong nghiên cứu này, phân tích độ tròn của phân vùng nhằm để tăng độ chính xác của việc nhận dạng đối tượng (Hình 4). Diện tích và chu vi của từng phân vùng cũng được ước tính. Tọa độ biên được sử dụng để ước tính diện tích và chu vi của từng phân vùng bằng cách trích xuất các hàm hình thái và biên. Giá trị độ tròn của từng phân vùng được xác định bởi công thức: 2 4 i i i A R p π = , (1) trong đó, Ri, Ai, và pi lần lượt là giá trị độ tròn, diện tích và chu vi của từng phân vùng. Giá trị độ tròn bằng 1 cho hình tròn và nhỏ hơn 1 cho các hình dạng khác. Sử dụng giá trị tính toán diện tích của từng phân vùng để loại bỏ nhiễu và giữ lại vùng đối tượng cần quan tâm (Hình 5). Hình 1. Sơ đồ phương pháp ước lượng vị trí và hướng của đối tượng Hình 2. Hệ thống quan sát và đèn hiệu. Hình 3. Phân đoạn vùng đối tượng theo màu Hình 4. Tìm đường biên của đối tượng Hình 5. Kết quả khử nhiễu 2.4. Xác định tâm đối tượng Sau khi tách được đối tượng ra khỏi nền và khoanh vùng đối tượng bằng đường bao quanh contours, tiếp theo ta tìm tâm của đối tượng, để xác JST: Engineering and Technology for Sustainable Development Vol. 1, Issue 2, April 2021, 065-071 67 định được tọa độ tâm của đối tượng ta phải tìm mô- men của phân vùng được quan tâm [8]. Phương trình toán của mô-men được biểu diễn như ở công thức (2) ( ) ( )nn x c f x dxµ +∞ −∞ = −∫ , (2) trong đó, có thn mô-men xung quanh điểm c. Khi ta xét trên không gian 2D, ta có hai biến độc lập để biểu diễn cho công thức (1). Vậy công thức được biểu diễn lại như (3): ( ) ( ) ( ), , nm m n x yx c x c f x y dxdyµ = − −∫∫ . (3) Ở đây, hàm ( ),f x y là một hàm liên tục. Vì vậy, ta phải rời rạc hóa từng điểm ảnh theo công thức (4): ( ) ( ) ( ), 0 0 , nm m n x y x y x c y c f x yµ ∞ ∞ = = = − −∑∑ . (4) Sau khi ta tính được vùng chứa ảnh nhị phân của đối tượng, ta cần tính mô-men thứ 0. ( )0 00,0 0 0 , w h x y x y f x yµ = = = ∑∑ . (5) Phương trình được viết lại như sau khi bỏ qua 0x ,và 0y ( )0,0 0 0 , w h x y f x yµ = = = ∑∑ . (6) Để xác định tâm của ảnh đối tượng, ta cần tính trên 2 trục tọa độ: 1,0 0,1 0,0 0,0 ,centroid µ µ µ µ = . (7) Tổng số điểm ảnh cần xét sẽ được tổng hợp lại và biểu diễn như sau: ( ) ( ) , , , . x y sum xf x y sum yf x y = = ∑∑ ∑∑ (8) Sau đó, ta lấy trung bình bằng cách chia cho tổng số điểm ảnh. 1,0 0,1 0,0 0,0 , .yx sumsum µ µ µ µ = = (9) Đối với các hàm trong OpenCV, thì tọa độ tâm được tính như sau: [ ] [ ]( ) [ ] [ ]( ) int " 10" / " 00" , int " 01" / " 00" . x y c M m M m c M m M m = = (10) Kết quả xác định tâm của đối tượng được thể hiện trong Hình 6. 2.5. Ước lượng vị trí và hướng đối tượng 2.5.1. Mô hình pinhole camera Mô hình pinhole camera có bốn hệ tọa độ được sử dụng: hệ tọa độ toàn cầu, hệ tọa độ camera, hệ tọa độ ảnh và hệ tọa độ điểm ảnh [9]. Trong các hệ tọa độ, hệ tọa độ ảnh và điểm ảnh đều nằm trên mặt phẳng ảnh nhưng điểm góc và hướng tọa độ đều khác nhau. Ảnh được thu thập bởi Baslar camera được chiếu lên các mặt phẳng ảnh. Đối với hệ tọa độ toàn cầu, mô hình pinhole camera cần phải đáp ứng yêu cầu. Dựa trên định nghĩa của mô hình pinhole camera, điểm P trên tọa độ toàn cầu được chiếu lên mặt phẳng ảnh ( P′ ) thông qua hệ tọa độ camera. Theo lý thuyết về mô hình pinhole camera 0 0 0 0 0 0 1 0 0 1 0 1 c c c c x x f y z y f z = , (11) trong đó, (x, y) là tọa độ vật lý của điểm 'P dưới hệ tọa độ ảnh, và ( , , )c c cx y z là tọa độ điểm P dưới hệ tọa độ camera. Và f là trọng tâm của camera. Ảnh được lưu trữ trên máy tính dưới dạng số, Chúng ta tạo ra một hệ tọa độ điểm ảnh trên mặt phẳng ảnh. Như được trình bài Hình 3, ( , )u v là hệ tọa độ điểm ảnh được mô tả ở trên. Mối liên hệ giửa hệ tọa độ ảnh và điểm ảnh được trình bày thông qua công thức 0 0 0 0 , 1 0 0 1 1 y x y y x d d u y d d v µ µ − = − (12) trong đó, dx, dy mô tả số điểm ảnh trong kích thước đơn vị vật lý. Để so sánh hệ tọa độ camera với hệ tọa độ toàn cầu được thể hiện qua công thức như sau: 0 1 1 1 c w c w c w x x y y z z = R t , (13) với ( , , )w w wx y z là tọa độ của điểm P trong hệ tọa độ toàn cầu. R là một mà trận xoay với kích thước 3 3× , t là ma trận dịch chuyển với kích thước 3 1× . Từ phương trình (1), (2), (3), mối quan hệ giữa hệ tọa độ thế giới và điểm ảnh có thể bắt nguồn từ: 0 0 0 0 0 0 0 1 1 0 0 1 0 1 w x w c y w x u a y z v a v z µ = R t , (14) JST: Engineering and Technology for Sustainable Development Vol. 1, Issue 2, April 2021, 065-071 68 trong đó, ,x y x y f fa a d d = = . Do đó, tọa độ 'p dễ dàng đạt được trên hệ tọa độ điểm ảnh từ hệ tọa độ toàn cầu. 2.5.2. Ước lượng khoảng cách Để xác định vị trí và hướng của đối tượng trên hệ tọa độ toàn cầu ta cần truy vấn thông tin 2D được mô tả phần trên. Xây dựng công thức ước lượng khoảng cách có nghĩa là thiết lập một công thức mô tả mối quan hệ giữa độ lớn điểm ảnh và khoảng cách từ camera đến đối tượng (Hình 7). Trong hệ tọa độ toàn cầu ( ), ,w w wx y z , đường kính của đối tượng là L. Trong hệ tọa độ camera ( ), ,c c cx y z , đường kính của đối tượng là l, tiêu cự là f, khoảng cách từ camera đến đối tượng cần tính là d. Dựa trên nguyên lý hình ảnh pinhole và tam giác đồng dạng, công thức dễ dàng được xác định như sau: L d f l = . (15) 2.5.3. Ước lượng vị trí và hướng Để dự ước lượng vị trí và hướng của đối tượng cho việc dự đoán quỹ đạo container, đầu tiên hệ thống xây dựng một mặt phẳng dự đoán bằng cách sử dụng phân đoạn mặt phẳng. Sau đó, một hệ tọa độ được xây dựng trên mặt phẳng dự đoán. Hình 8 cho thấy quy trình từng bước của thuật toán, mối quan hệ giữa các điểm mục tiêu và camera được thể hiện trong Hình 9. • Bước 1: Xác định tọa độ đối tượng trên ảnh RGB 2D. Bước này được hoàn thành bởi phương pháp nhận dạng ảnh và xác định tâm được mô tả phần trên; • Bước 2: Thu thập các điểm tương đối dựa trên tọa độ các điểm mục tiêu trên ảnh RGB 2D và chọn các tọa độ như A, B, và C. Tọa độ C là trọng tâm của 2 điểm A và B; • Bước 3: Lập bản đồ và thu thập thông tin 3D từ các điểm mẫu (A, B, và C) để tạo các điểm A′ , B′ và C′ tương ứng; • Bước 4: Tạo mặt phẳng dự đoán trong không gian 3D dựa trên các điểm A′ , B′ và C′ (có cùng giá trị trục z) sử dụng phương pháp phân đoạn mặt phẳng; • Bước 5: Sử dụng các điểm A′ , B′ và C′ để tạo các điểm A′′ , B′′ và C′′ tương ứng trên mặt phẳng dự đoán; • Bước 6: Tạo hai vector C A′′ ′′ và C B′′ ′′ ; • Bước 7: Tạo vector pháp tuyến 1C N′′ từ hai vector C A′′ ′′ và C B′′ ′′ ; • Bước 8: Tạo thêm một vector pháp tuyến 2C N′′ từ 2 vector 1C N′′ và C B′′ ′′ . Dựng hệ tọa độ Descartes 1 2N B N′′ ; • Bước 9: Chiếu hệ tọa độ mục tiêu (container) lên hệ tọa độ camera để đạt được ma trận xoay. Cuối cùng, hệ thống đạt được thông tin chính xác về vị trí và hướng của container so với hệ tọa độ camera (Hình 10). Phép biến đổi của container đến camera được thể hiện dưới dạng ma trận đồng nhất 0 CT (ma trận biến đổi từ camera đên đối tượng), 11 12 13 21 22 23 0 31 32 330 1 0 0 0 1 x yC z r r r t r r r t r r r t = = R t T . (16) Hình 6. Xác định tâm đối tượng Hình 7. Sơ đồ nguyên lý ước lượng khoảng cách sử dụng camera đơn đến đối tượng JST: Engineering and Technology for Sustainable Development Vol. 1, Issue 2, April 2021, 065-071 69 Hình 8. Quy trình xây dựng hệ tọa độ để xác định ma trận xoay liên quan đến camera. Bảng 1. Kết quả đo đạc của hệ thống Tập ảnh Tập 1 Tập 2 Tập 3 Tổng Số lượng mẫu 28 29 28 85 Sai lệch trung bình (cm) 1,1 0,82 0,76 0,89 Sai số trung bình (%) 0,21 0,22 0,21 0,21 Độ chính xác trung bình (%) 99,79 99,78 99,79 99,79 Hình 9. Mối quan hệ giữa các điểm mục tiêu và camera. Hình 10. Kết quả xác định vị trí và hướng của container 3. Kết quả nghiên cứu Để đánh giá hiệu quả của phương pháp đề nghị, chúng tôi cho tiến hành chạy hệ thống để đo khoảng cách từ hệ camera tới vị trí container với 85 giá trị, chia thành 3 tập dữ liệu tương ứng với 3 lần đo khác nhau, sau đó so sánh với kết quả thực tế đo được (Hình 11). Đồng thời tính toán sai số giữa giá trị khoảng cách của hệ thống đo được và thực tế (Hình 12). Bảng số liệu tổng hợp được trình bày ở Bảng 1. Khoảng cách và góc lệch theo thời gian được thay đổi giá trị để đánh giá đáp ứng của hệ thống, kết quả được trình bày trong Hình 13 và Hình 14. Thực nghiệm được tiến hành trên máy tính nhúng của hãng Cincoze, dòng máy DS-1000 với model DS-1102 được trang bị bộ vi xử lý Intel® Core™ i5-6500 cho xung nhịp 3,2Ghz-3,6Ghz, RAM 16GB, chạy hệ điều hành Window 10 và chương trình Visual Studio 2019 cùng mã nguồn mở OpenCV3.4.9. Ảnh được chụp theo chiều thẳng đứng từ trên cẩu trục xuống vị trí container bằng máy ảnh công nghiệp JST: Engineering and Technology for Sustainable Development Vol. 1, Issue 2, April 2021, 065-071 70 Basler Ace acA1920-40gc kết hợp với ống kính Basler f16mm trong điều kiện ánh sáng ban ngày bình thường. Các ảnh thu được sẽ được tiến hành xử lý về dạng ảnh jpeg với độ phân giải 1200x800. Hình 15 minh họa kết quả thực nghiệm của hệ thống. Hình 11. Đồ thị so sánh kết quả đo được và thực tế Hình 12. Đồ thị biểu diễn kết quả sai số. Hình 13. Đáp ứng khoảng cách của hệ thống Hình 14. Đáp ứng góc lệch của hệ thống Hình 15. Kết quả thực nghiệm hệ thống. 4. Kết luận Trong nghiên cứu này, chúng tôi đã đề xuất một giải thuật xử lý ảnh hiệu quả để phát hiện, xác định khoảng cách từ hệ camera đến vị trí container và góc lệch của marker đặt trên bề mặt container so với phương ngang. Kết quả của nghiên cứu này có thể là tiền đề để phát triển một hệ thống bốc dỡ container tự động. Kết quả thực nghiệm cho thấy độ chính xác trung bình của phương pháp đề xuất đạt được lên tới 99.79%. Vì vậy, có thể áp dụng cho bài toán phát hiện, xác định khoảng cách từ hệ camera đến vị trí container và góc lệch của marker đặt trên bề mặt container so với phương ngang. Trong tương lai, chúng tôi sẽ tiến hành nghiên cứu, phân tích phương pháp đề xuất, từ đó cải tiến giải thuật để làm giảm thời gian xử lý cũng như tăng độ chính xác. Đồng thời tiến hành thiết kế, thử nghiệm mô hình bốc dỡ container tự động. Lời cảm ơn Nghiên cứu này được tài trợ bởi Quỹ phát triển khoa học và công nghệ quốc gia (NAFOSTED) trong đề tài mã số “107.01-2017.320”. Tài liệu tham khảo [1] Li Da Wei, Eung-Joo Lee. Real-Time Container Shape and Range Recognition for Implementation of Container Auto-Landing System. Journal of Korea Multimedia Society 12 (6), 2009, pp. 794-803. [2] Hee-Joo Yoon, Young-Chul Hwang, Eui-Young Cha. Real-time Container Position Estimation Method using Stereo Vision for Container Auto-Landing System. International Conference on Control, Automation and Systems, 2010, pp. 872-876. [3] Anh Viet Nguyen, Young-Yeol Cho, Eung-Joo Lee. Container Dimension Detection and 3D Modeling based on Stereo Vision. MIT, 2008, pp. 207-210. [4] Wang, Shikai. Color Image Segmentation based on Color Similarity. International Conference on Computational Intelligence and Software Engineering, 2009, pp. 1-4. [5] Tse-Wei Chen, Yi-Ling Chen, Shao-Yi Chien, Fast Image Segmentation based on K-Means Clustering with Histograms in HSV Color Space, IEEE 10th Workshop on Multimedia Signal Processing, 2008, pp. 322-325. JST: Engineering and Technology for Sustainable Development Vol. 1, Issue 2, April 2021, 065-071 71 [6] Rafael C. Gonzalez, Richard E. Woods, Digital Image Processing, Pearson Prentice Hall, 2008. [7] Van Otterloo, Peter J, A Contour Oriented Approach to Shape Analysis, New York Prentice Hall, 1991. [8] Chi Cuong Tran, Dinh Tu Nguyen, Hoang Dang Le, Trong Hieu Luu, Quoc Bao Truong. Designing the Yellow Head Virus Syndrome Recognition Application for Shrimp on an Embedded System. The Interdisciplinary Research Journal 6 (2), 2019, pp. 48- 63. [9] Kostas Daniilidis, Reinhard Klette, Imaging Beyond the Pinhole Camera, Springer, 2006.

File đính kèm:

nhan_dang_vi_tri_tai_tren_cau_truc_container_bang_camera.pdf

nhan_dang_vi_tri_tai_tren_cau_truc_container_bang_camera.pdf