Nghiên cứu bài toán tránh vật cản cho rô bốt tự hành trên cơ sở ứng dụng học sâu tăng cường DQN

Các phương pháp tránh chướng ngại vật cục bộ luôn hoạt động bằng cách tính toán

hướng cho robot đi vào nhưng không tính đến động lực học của robot. Ví dụ: các cách tiếp

cận Trường thế năng [1, 8] sử dụng tổng các vectơ đặc trưng của lực hút và lực đẩy để tính

toán mục tiêu robot mong muốn. Việc kiểm soát tốc độ được thực hiện bằng cách chọn

vận tốc tỷ lệ với độ lớn của vectơ thế năng. Phương pháp Biểu đồ trường Vector [2] cải

thiện phương pháp này bằng cách tính toán biểu đồ cực một chiều, sau đó được xử lý để

phát hiện các khu vực mở để robot di chuyển qua. Vận tốc của robot, được chọn sau khi đã

chọn hướng, tỷ lệ thuận với khoảng cách đến chướng ngại vật phía trước. Mặc dù phương

pháp này tạo ra sự di chuyển mượt mà hơn và có thể xử lý cả các khe hẹp và rộng nhưng

giống như phương pháp Trường thế năng, không tính đến thực tế là khi robot quay chúng

thường di chuyển dọc theo các cung, thay vì theo đường thẳng. Trong môi trường lộn xộn,

động lực học robot có thể rất quan trọng.

Trong khi các phương pháp tính đến động lực học của robot đã được nghiên cứu trong

bối cảnh lập kế hoạch lộ trình ngoại tuyến [4, 9], các phương pháp này thường quá tốn

kém về mặt tính toán để tránh chướng ngại vật cục bộ nhanh.

Tuy nhiên, gần đây, một số phương pháp tránh chướng ngại vật cục bộ đã kết hợp động

lực học của xe, chọn các lệnh lái thay vì hướng di chuyển. Phương pháp Trường góc lái [5]

sử dụng các đường cong tiếp tuyến với các chướng ngại vật để hạn chế một không gian liên

tục (trong trường hợp này đó là không gian một chiều của các góc lái). Độ cong và khoảng

cách vòng cung liên quan được sử dụng để cấm di chuyển trên phạm vi góc lái. Phương pháp

tính toán các ràng buộc cho một số ngưỡng khoảng cách và cố gắng di chuyển dọc theo

chiều tự do nhất. Một phương pháp tương tự cho điều hướng trong nhà tốc độ cao hoạt động

trong không gian vận tốc đã được phát triển sớm hơn một chút nhưng độc lập [3]. Phương

pháp này xem xét một tập hợp các vòng cung riêng biệt, bị hạn chế bởi động lực học của xe

và chọn một vòng quay gần nhất theo hướng mục tiêu, trong khi đảm bảo rằng robot không

gặp chướng ngại vật trong vài giây di chuyển tiếp theo. Phương pháp này đầu tiên sử dụng

cách tiếp cận hai bước để chọn độ cong và vận tốc; Sau đó, áp dụng phương pháp một bước

để đồng thời chọn độ cong và vận tốc [6]. Một cách tiếp cận tương tự đã được phát triển cho

điều hướng ngoài trời [7]. Ở đây, động lực học của xe được xem xét một cách đầy đủ, do đó,

đường dẫn không nhất thiết phải là một vòng cung tròn, một phép đo khả năng di chuyển

được tính cho mỗi đường và đường có giá trị tốt nhất được chọn. Cả hai phương pháp này

đều có một vấn đề là khi chỉ phân tích một tập hợp các cung tròn rời rạc, các đường dẫn tốt

có thể rơi vào các vết nứt và không được xem xét.

Trang 1

Trang 2

Trang 3

Trang 4

Trang 5

Trang 6

Trang 7

Trang 8

Trang 9

Tóm tắt nội dung tài liệu: Nghiên cứu bài toán tránh vật cản cho rô bốt tự hành trên cơ sở ứng dụng học sâu tăng cường DQN

Kỹ thuật Điều khiển – Tự động hóa

Đ. N. Thắng, P. T. Dũng, N. Q. Hùng, “Nghiên cứu bài toán học sâu tăng cường DQN.” 48

NGHIÊN CỨU BÀI TOÁN TRÁNH VẬT CẢN

CHO RÔ BỐT TỰ HÀNH TRÊN CƠ SỞ ỨNG DỤNG

HỌC SÂU TĂNG CƯỜNG DQN

Đỗ Nam Thắng1*, Phạm Trung Dũng2, Nguyễn Quang Hùng1

Tóm tắt: Bài toán tránh vật cản động cho robot tự hành trên cơ sở ứng dụng các

công cụ trí tuệ nhân tạo là một hướng nghiên cứu thuộc lĩnh vực điều khiển robot

thông minh. Trong bài báo này, chúng tôi giải quyết bài toán thông qua dự báo

hành vi và kỹ thuật học sâu tăng cường QDN (Deep Q learning). Robot tự hành

trong nghiên cứu là loại robot có 2 bánh xe chủ động điều khiển độc lập. Các kết

quả thu được chứng tỏ tính hiệu quả của hướng tiếp cận, robot có thể dự đoán hành

vi của vật cản dựa trên bộ nhớ hành vi trước đó mà không cần mô hình hóa robot.

Từ khóa: Robot tự hành; Tránh va chạm chủ động; Thuật toán DQN; Turtlebot3.

1. GIỚI THIỆU

Các phương pháp tránh chướng ngại vật cục bộ luôn hoạt động bằng cách tính toán

hướng cho robot đi vào nhưng không tính đến động lực học của robot. Ví dụ: các cách tiếp

cận Trường thế năng [1, 8] sử dụng tổng các vectơ đặc trưng của lực hút và lực đẩy để tính

toán mục tiêu robot mong muốn. Việc kiểm soát tốc độ được thực hiện bằng cách chọn

vận tốc tỷ lệ với độ lớn của vectơ thế năng. Phương pháp Biểu đồ trường Vector [2] cải

thiện phương pháp này bằng cách tính toán biểu đồ cực một chiều, sau đó được xử lý để

phát hiện các khu vực mở để robot di chuyển qua. Vận tốc của robot, được chọn sau khi đã

chọn hướng, tỷ lệ thuận với khoảng cách đến chướng ngại vật phía trước. Mặc dù phương

pháp này tạo ra sự di chuyển mượt mà hơn và có thể xử lý cả các khe hẹp và rộng nhưng

giống như phương pháp Trường thế năng, không tính đến thực tế là khi robot quay chúng

thường di chuyển dọc theo các cung, thay vì theo đường thẳng. Trong môi trường lộn xộn,

động lực học robot có thể rất quan trọng.

Trong khi các phương pháp tính đến động lực học của robot đã được nghiên cứu trong

bối cảnh lập kế hoạch lộ trình ngoại tuyến [4, 9], các phương pháp này thường quá tốn

kém về mặt tính toán để tránh chướng ngại vật cục bộ nhanh.

Tuy nhiên, gần đây, một số phương pháp tránh chướng ngại vật cục bộ đã kết hợp động

lực học của xe, chọn các lệnh lái thay vì hướng di chuyển. Phương pháp Trường góc lái [5]

sử dụng các đường cong tiếp tuyến với các chướng ngại vật để hạn chế một không gian liên

tục (trong trường hợp này đó là không gian một chiều của các góc lái). Độ cong và khoảng

cách vòng cung liên quan được sử dụng để cấm di chuyển trên phạm vi góc lái. Phương pháp

tính toán các ràng buộc cho một số ngưỡng khoảng cách và cố gắng di chuyển dọc theo

chiều tự do nhất. Một phương pháp tương tự cho điều hướng trong nhà tốc độ cao hoạt động

trong không gian vận tốc đã được phát triển sớm hơn một chút nhưng độc lập [3]. Phương

pháp này xem xét một tập hợp các vòng cung riêng biệt, bị hạn chế bởi động lực học của xe

và chọn một vòng quay gần nhất theo hướng mục tiêu, trong khi đảm bảo rằng robot không

gặp chướng ngại vật trong vài giây di chuyển tiếp theo. Phương pháp này đầu tiên sử dụng

cách tiếp cận hai bước để chọn độ cong và vận tốc; Sau đó, áp dụng phương pháp một bước

để đồng thời chọn độ cong và vận tốc [6]. Một cách tiếp cận tương tự đã được phát triển cho

điều hướng ngoài trời [7]. Ở đây, động lực học của xe được xem xét một cách đầy đủ, do đó,

đường dẫn không nhất thiết phải là một vòng cung tròn, một phép đo khả năng di chuyển

được tính cho mỗi đường và đường có giá trị tốt nhất được chọn. Cả hai phương pháp này

đều có một vấn đề là khi chỉ phân tích một tập hợp các cung tròn rời rạc, các đường dẫn tốt

có thể rơi vào các vết nứt và không được xem xét.

Nghiên cứu khoa học công nghệ

Tạp chí Nghiên cứu KH&CN quân sự, Số Đặc san Hội thảo Quốc gia FEE, 10 - 2020 49

Phương pháp vận tốc cong (CVM - Curvature-Velocity Method) để tránh chướng ngại

vật cục bộ coi vấn đề trên như một bài toán tối ưu hóa bị hạn chế trong không gian vận tốc

của robot [10]. Ưu điểm của phương pháp nghiên cứu này là khả năng kiểm soát đồng thời

tốc độ và hướng mục tiêu của robot, dễ dàng kết hợp các ràng buộc từ cả môi trường và

động lực học của robot và khả năng xử lý sự đánh đổi giữa tốc độ, an toàn và vô hướng.

CVM đạt được hiệu suất thời gian thực bằng cách xấp xỉ khoảng cách robot có thể di

chuyển dọc theo một độ cong nhất định trước khi gặp chướng ngại vật. Phép tính gần đúng

là một hàm không đổi, được xác định bởi các đường cong tiếp tuyến với các chướng ngại

vật. Các hạn chế vận tốc bổ sung được thêm vào dựa trên các giới hạn vật lý của robot và

mong muốn tránh xa chướng ngại vật, hoặc ít nhất là di chuyển chậm khi vượt qua các

chướng ngại vật gần đó.

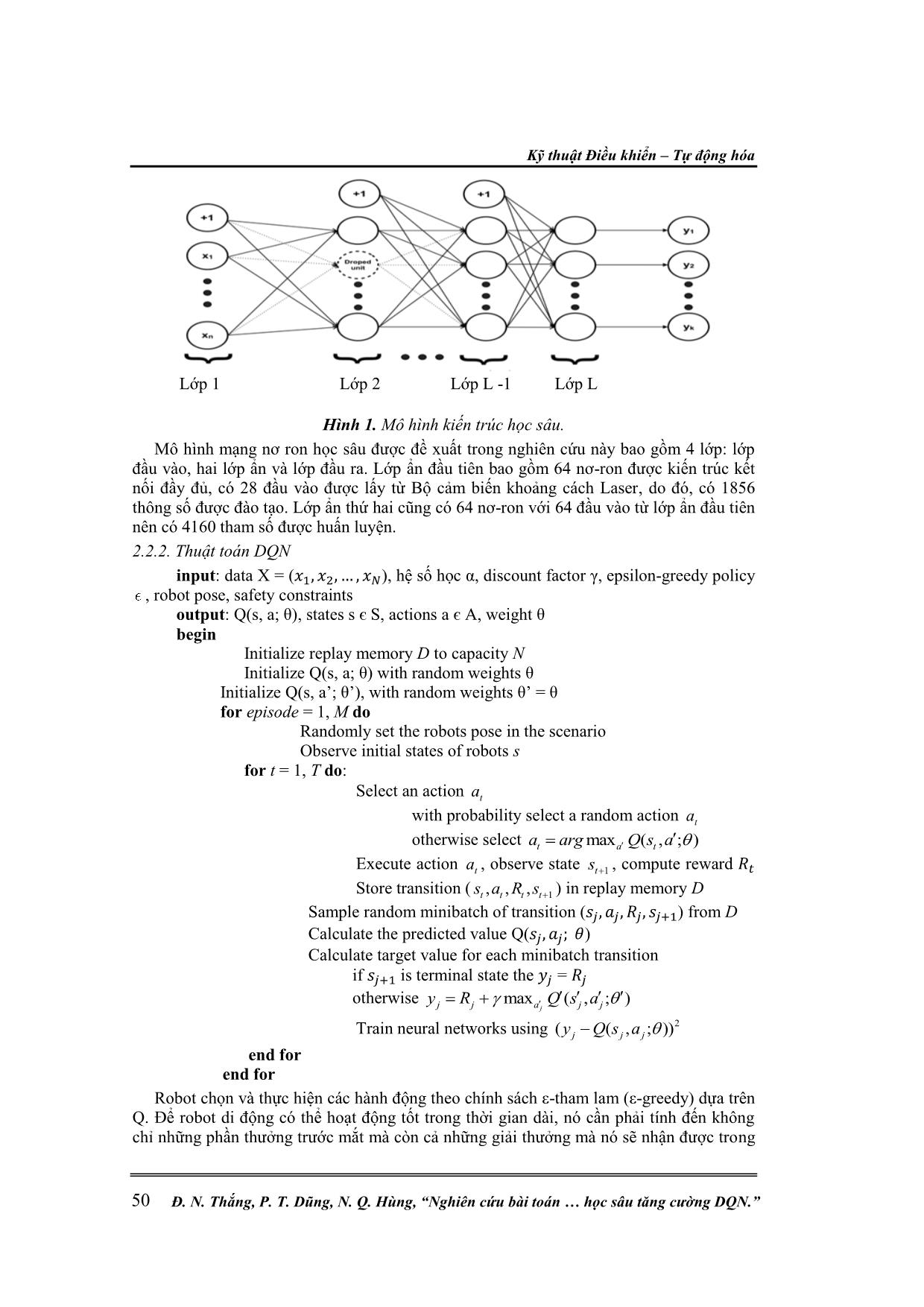

Trong những năm gần đây, thuật toán DQN (Deep Q Learning) đã được phát triển và

áp dụng vào nhiều lĩnh vực khác nhau, trong đó có bài toán dẫn hướng cho robot. Trong

nghiên cứu này, chún ... e state 1ts , compute reward

Store transition (

1, , ,t t t ts a R s ) in replay memory D

Sample random minibatch of transition ( ) from D

Calculate the predicted value Q( )

Calculate target value for each minibatch transition

if is terminal state the =

otherwise max ( , ; )

jj j a j j

y R Q s a

Train neural networks using 2( ( , ; ))j j jy Q s a

end for

end for

Robot chọn và thực hiện các hành động theo chính sách ε-tham lam (ε-greedy) dựa trên

Q. Để robot di động có thể hoạt động tốt trong thời gian dài, nó cần phải tính đến không

chỉ những phần thưởng trước mắt mà còn cả những giải thưởng mà nó sẽ nhận được trong

Lớp 1 Lớp 2 Lớp L -1 Lớp L

Nghiên cứu khoa học công nghệ

Tạp chí Nghiên cứu KH&CN quân sự, Số Đặc san Hội thảo Quốc gia FEE, 10 - 2020 51

tương lai. Ngoài ra, vì môi trường là ngẫu nhiên, robot không bao giờ có thể chắc chắn, nó

sẽ nhận được phần thưởng tương tự vào lần tiếp theo khi thực hiện các hành động tương

tự. Robot càng di chuyển trong tương lai, nó càng có thể phân kỳ. Vì lý do đó, trong

nghiên cứu này, chúng tôi sử dụng phần thưởng giảm giá trong tương lai. Lợi nhuận của

hệ số suy giảm trong tương lai tại thời điểm t được xác định như sau:

2

1 2 ... ,0 1

T t

t t t t TR r r r r

(3)

Trong đó, rt là phần thưởng trực tiếp và T là bước thời gian mà hành động robot kết

thúc, phần thưởng trong tương lai càng nhiều, robot càng ít xem xét nó. Khi đặt hệ số khấu

hao γ = 0, thì việc chọn và thực hiện hành động của robot sẽ bị thiển cận và chỉ dựa vào

phần thưởng trực tiếp. Nếu muốn cân bằng giữa phần thưởng trực tiếp và trong tương lai,

ta nên đặt hệ số khấu hao γ = 0.9. Khi môi trường mang tính quyết định và các hành động

tương tự luôn dẫn đến cùng một phần thưởng, thì ta có thể đặt hệ số khấu hao γ = 1. Mục

tiêu của robot là tương tác với môi trường bằng cách chọn các hành động theo cách tối đa

hóa các phần thưởng trong tương lai. Ta sử dụng kỹ thuật được gọi là tái hiện trải nghiệm

(experience replay), trong đó, ta lưu lại trải nghiệm của robot ở mỗi bước thời gian, =

( , , , ), trong tập dữ liệu = { ,, }, được gộp lại qua nhiều chu kỳ học

(episode) (khi kết thúc một chu kỳ học) vào bộ nhớ tái hiện (replay memory).

Trong quá trình đào tạo của các mạng nơron, các mẫu ngẫu nhiên từ bộ nhớ phát lại

được sử dụng thay vì chuyển đổi gần đây nhất. Điều này phá vỡ sự giống nhau của các

mẫu đào tạo tiếp theo, nếu không có thể đẩy mạng vào mức tối thiểu cục bộ. Ngoài ra,

kinh nghiệm phát lại làm cho nhiệm vụ đào tạo tương tự như học tập có giám sát thông

thường, giúp đơn giản hóa việc gỡ lỗi và kiểm tra thuật toán. Người ta thực sự có thể thu

thập tất cả những kinh nghiệm từ chuyên gia của con người và huấn luyện các mạng nơron

về những điều này. Để cập nhật trọng số của các mạng nơron, trước tiên, lấy mẫu chuyển

tiếp ngẫu nhiên từ bộ nhớ phát lại D với kích thước bộ nhớ hữu hạn N. Với mỗi lần chuyển

đổi nhất định, thuật toán thực hiện các bước sau:

- Bước 1: Thực hiện một chuyển tiếp qua các mạng nơron cho trạng thái hiện tại js để

có được giá trị dự đoán Q( ).

- Bước 2: Nếu quá trình chuyển đổi được lấy mẫu là một mẫu va chạm, việc đánh giá

cho cặp ( này được đặt trực tiếp làm phần thưởng kết thúc. Mặt khác, thực hiện

chuyển tiếp các mạng nơron cho trạng thái tiếp theo s’, tính toán đầu ra mạng tổng thể tối

đa

và tính toán mục tiêu cho hành động bằng phương trình Bellman

(r +

). Đối với tất cả các hành động khác, đặt giá trị mục tiêu giống

như giá trị được trả về ban đầu từ bước 1.

- Bước 3: Thuật toán cập nhật Q-learning sử dụng hàm mất mát (loss function) sau:

2

1

1

( ) ( ( , ; ))

n

j j j

i

L y Q x a

N

(4)

Sử dụng chức năng hàm mất mát, các trọng số của mạng nơ ron sẽ được cập nhật thông

qua việc lan truyền ngược và giảm độ dốc ngẫu nhiên. Khi quá trình đào tạo hoàn thành,

robot di động sẽ lưu các mạng nơron được đào tạo vào não của nó và sẽ sử dụng nó trong

các quá trình thử nghiệm và làm việc trong tương lai.

3. MÔ PHỎNG ĐÁNH GIÁ HIỆU QUẢ THUẬT TOÁN

Trong nghiên cứu này, nhóm tác giả đã đề xuất phương pháp tránh vật cản sử dụng

thuật toán DQN cho một robot TurtleBot3 di động hai bánh sử dụng cảm biến LiDAR

Kỹ thuật Điều khiển – Tự động hóa

Đ. N. Thắng, P. T. Dũng, N. Q. Hùng, “Nghiên cứu bài toán học sâu tăng cường DQN.” 52

trong một môi trường không xác định. Cảm biến LiDAR sử dụng giá trị khoảng cách làm

trạng thái đầu vào của phương pháp học và từ đó hệ thống xác định hành động tiếp theo

chỉ bằng khoảng cách của chướng ngại vật đến robot di động. Trong quá trình này, do biến

động thường xuyên của giá trị hành động, các hành động tăng tốc/giảm tốc không tự nhiên

là bắt buộc, gây ra không chỉ hiện tượng sốc vật lý cho robot mà còn hiệu quả lái thấp.

Vấn đề đã được giải quyết bằng việc áp dụng bộ nhớ tái hiện để lưu trữ đầu ra của mạng.

Nghĩa là, các giá trị hành động được lưu trữ trong bộ nhớ và được nạp lại vào đầu vào một

lần nữa theo thứ tự hành động của mạng. Thử nghiệm được thực hiện trên một robot thực

tế sau khi học tăng cường trong các mô phỏng ROS-GAZEBO và tính hợp lệ của thuật

toán được xác minh thông qua phân tích số liệu thực nghiệm.

Thiết lập trạng thái:

Trạng thái là môi trường quan sát và mô tả vị trí hiện tại của robot. Ở đây, kích thước

trạng thái là 28 trong đó có 24 giá trị cảm biến khoảng cách Laser, khoảng cách đến mục

tiêu và góc tới mục tiêu.

Thiết lập hành động:

Hành động là những gì một robot có thể làm trong mỗi trạng thái. Ở đây, turtlebot3

luôn có vận tốc tuyến tính là 0,15 m/s. Tốc độ góc được xác định bằng hành động. Trong

nghiên cứu này, nhóm tác giả đã chọn một mô hình robot di động, chỉ có thể thực hiện

năm hành động có thể như sau:

Hành động Vận tốc góc (rad/s)

0 -1.5

1 -0.75

2 0

3 0.75

4 1.5

Thiết lập phần thưởng:

Khi turtlebot3 thực hiện một hành động trong trạng thái, nó sẽ nhận được phần thưởng.

Thiết kế phần thưởng là rất quan trọng cho việc học tập. Một phần thưởng có thể là tích cực

hoặc tiêu cực. Khi turtlebot3 đạt được mục tiêu, nó nhận được phần thưởng tích cực lớn. Khi

turtlebot3 va chạm với một chướng ngại vật, nó nhận được phần thưởng tiêu cực lớn.

Thiết lập các tham số:

Tham số Giá trị Mô tả

T 6000 Bước thời gian của một chu kỳ

γ 0.99 Hệ số khấu hao

α 0.00025

Tốc độ học tập. Nếu giá trị quá lớn, việc học không

hiệu quả và nếu quá nhỏ, thời gian học sẽ lâu.

ξ 1.0 Xác xuất chọn một hành động ngẫu nhiên

0.99

Tỷ lệ giảm của epsilon. Khi một chu kỳ kết thúc,

epsilon giảm.

0.05 Tối thiểu của epsilon.

batch_size 64 Kích thước của một nhóm các mẫu đào tạo.

train_start 64

Bắt đầu đào tạo nếu kích thước bộ nhớ phát lại lớn

hơn 64.

memory 1000000 Kích thước của bộ nhớ phát lại.

Nghiên cứu khoa học công nghệ

Tạp chí Nghiên cứu KH&CN quân sự, Số Đặc san Hội thảo Quốc gia FEE, 10 - 2020 53

Kết quả:

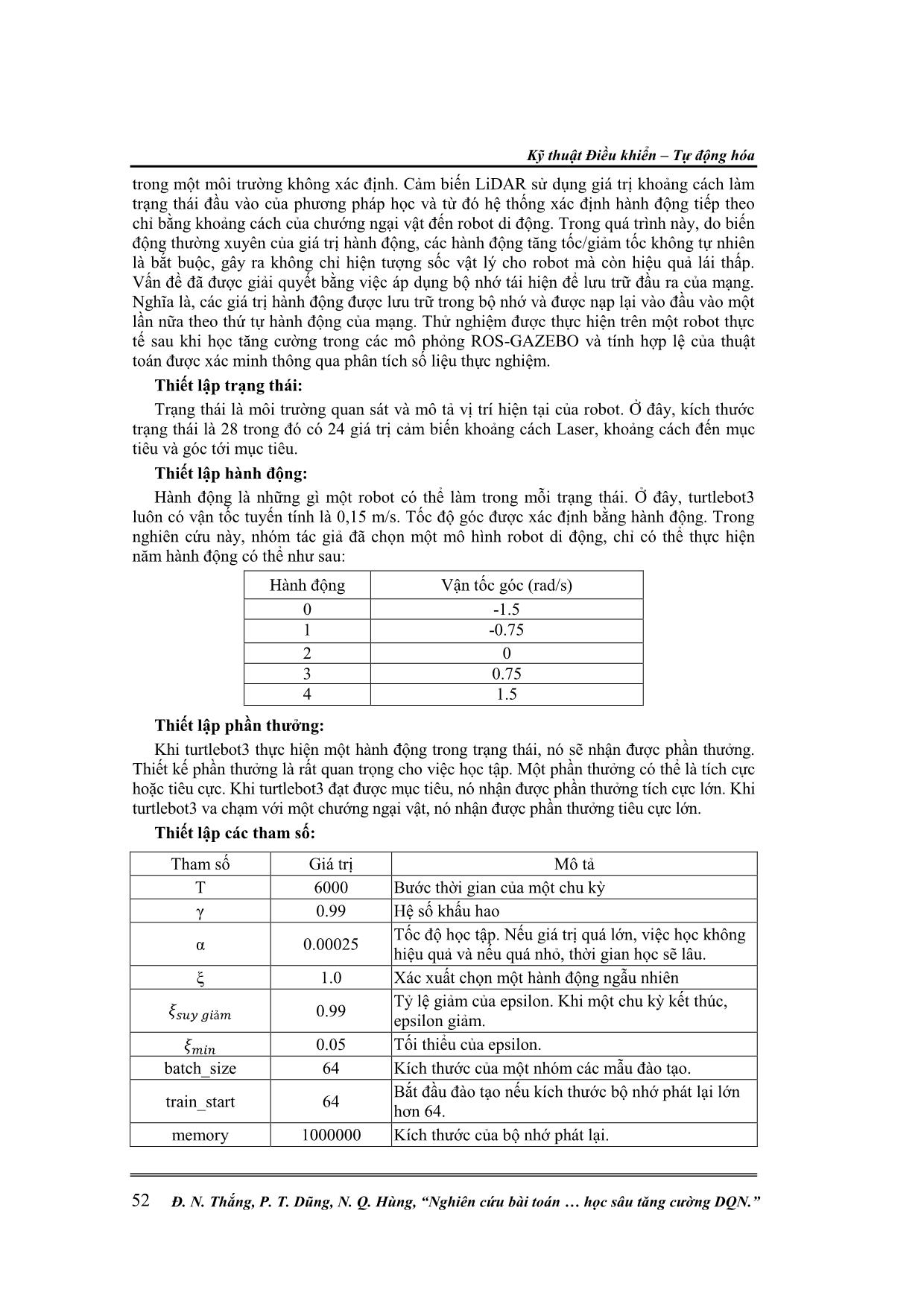

Để thu hẹp khoảng cách giữa môi trường mô phỏng và thế giới thực, nhóm tác giả đã

tạo ra một kịch bản giống như văn phòng mô phỏng trong Gazebo (hình 2). Trong môi

trường này, nhiều loại chướng ngại vật được đặt bao gồm tường, người đứng, chướng ngại

vật động, mục tiêu động và robot di động (turtlebot3) để thử nghiệm thuật toán điều hướng

được đề xuất. Robot di động được yêu cầu bắt kịp mục tiêu động trong khi tránh các

chướng ngại vật tĩnh.

Hình 2. Môi trường mô phỏng. Hình 3. Khu vực đào tạo trong môi trường

mô phỏng.

Quá trình đào tạo của robot có thể trải qua nhiều chu kỳ. Mỗi chu kỳ kết thúc khi robot

có được vị trí mục tiêu, chạm vào chướng ngại vật trên đường di chuyển của robot hoặc

khi hết thời gian cho mỗi chu kỳ.

Trong môi trường này, nhiều loại chướng ngại vật được đặt ngẫu nhiên bao gồm người

đứng, hai nhóm người đang nói chuyện bên cạnh bức tường để kiểm tra hiệu suất của thuật

toán điều hướng robot di động được đề xuất.

Nhiệm vụ của robot là tránh các chướng ngại vật bằng cách giữ khoảng cách an toàn

nhất định với chúng và đạt được các vị trí 9 mục tiêu (bảng 1), được phân bổ một cách

khoa học trong hành lang rộng 3 m được minh họa trong hình 3.

Bảng 1. Các vị trí 9 mục tiêu được sử dụng trong quá trình đào tạo.

Các vị trí mục tiêu Vị trí trục X Vị trí trục Y

1 4.28 11.10

2 -2.80 12.10

3 0.20 10.40

4 -0.30 12.08

5 -2.50 10.00

6 0.00 12.00

7 2.00 11.50

8 -1.30 11.00

9 1.50 12.00

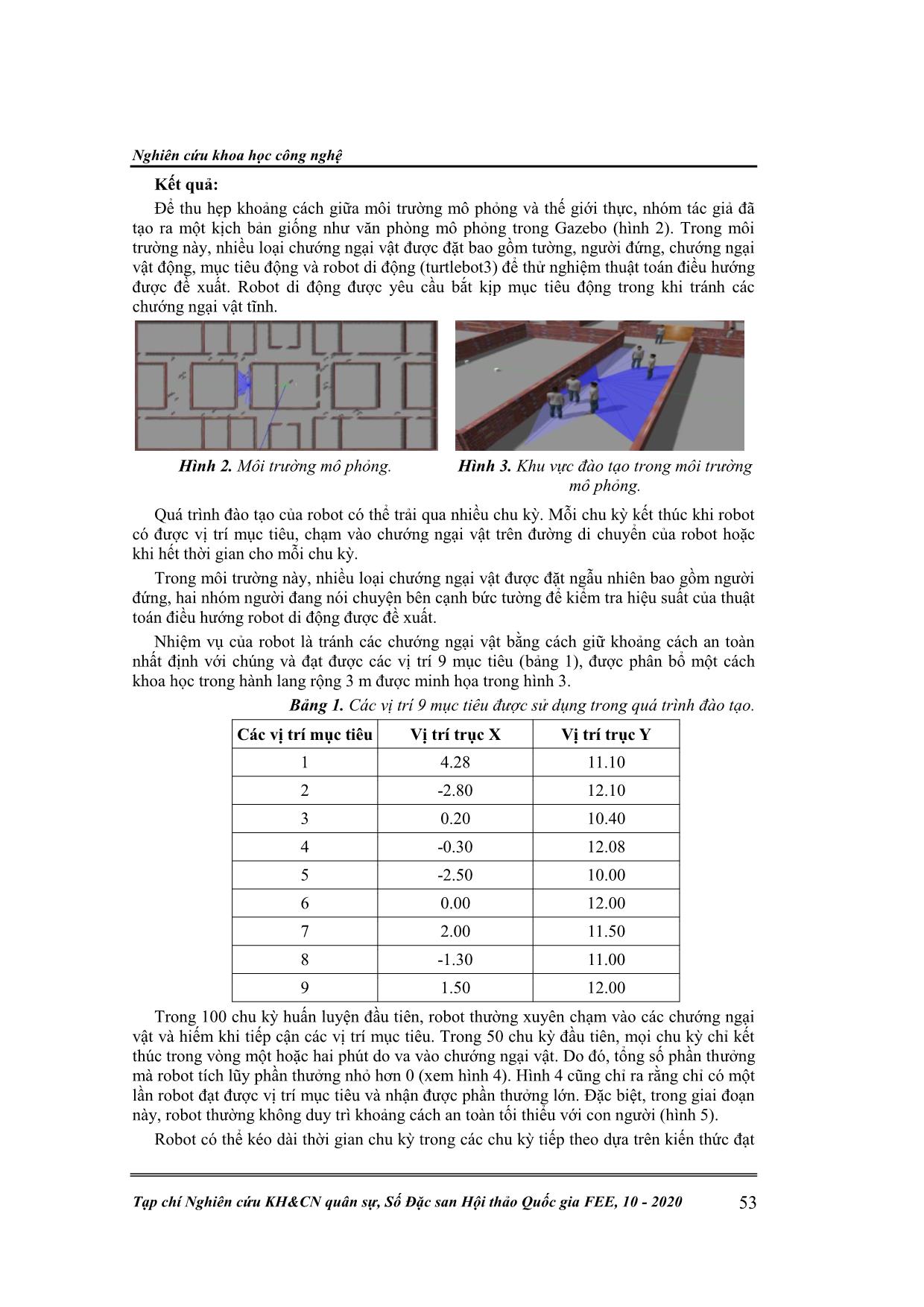

Trong 100 chu kỳ huấn luyện đầu tiên, robot thường xuyên chạm vào các chướng ngại

vật và hiếm khi tiếp cận các vị trí mục tiêu. Trong 50 chu kỳ đầu tiên, mọi chu kỳ chỉ kết

thúc trong vòng một hoặc hai phút do va vào chướng ngại vật. Do đó, tổng số phần thưởng

mà robot tích lũy phần thưởng nhỏ hơn 0 (xem hình 4). Hình 4 cũng chỉ ra rằng chỉ có một

lần robot đạt được vị trí mục tiêu và nhận được phần thưởng lớn. Đặc biệt, trong giai đoạn

này, robot thường không duy trì khoảng cách an toàn tối thiểu với con người (hình 5).

Robot có thể kéo dài thời gian chu kỳ trong các chu kỳ tiếp theo dựa trên kiến thức đạt

Kỹ thuật Điều khiển – Tự động hóa

Đ. N. Thắng, P. T. Dũng, N. Q. Hùng, “Nghiên cứu bài toán học sâu tăng cường DQN.” 54

được trong quá trình đào tạo. Mặc dù số lần robot đến đích bị hạn chế nhưng nhận thức về

robot về môi trường là rất đáng kể.

Hình 4. Tổng số phần thưởng đạt được trong 100 chu kỳ huấn luyện đầu tiên.

Hình 5. Khoảng cách tối thiểu giữa robot và người.

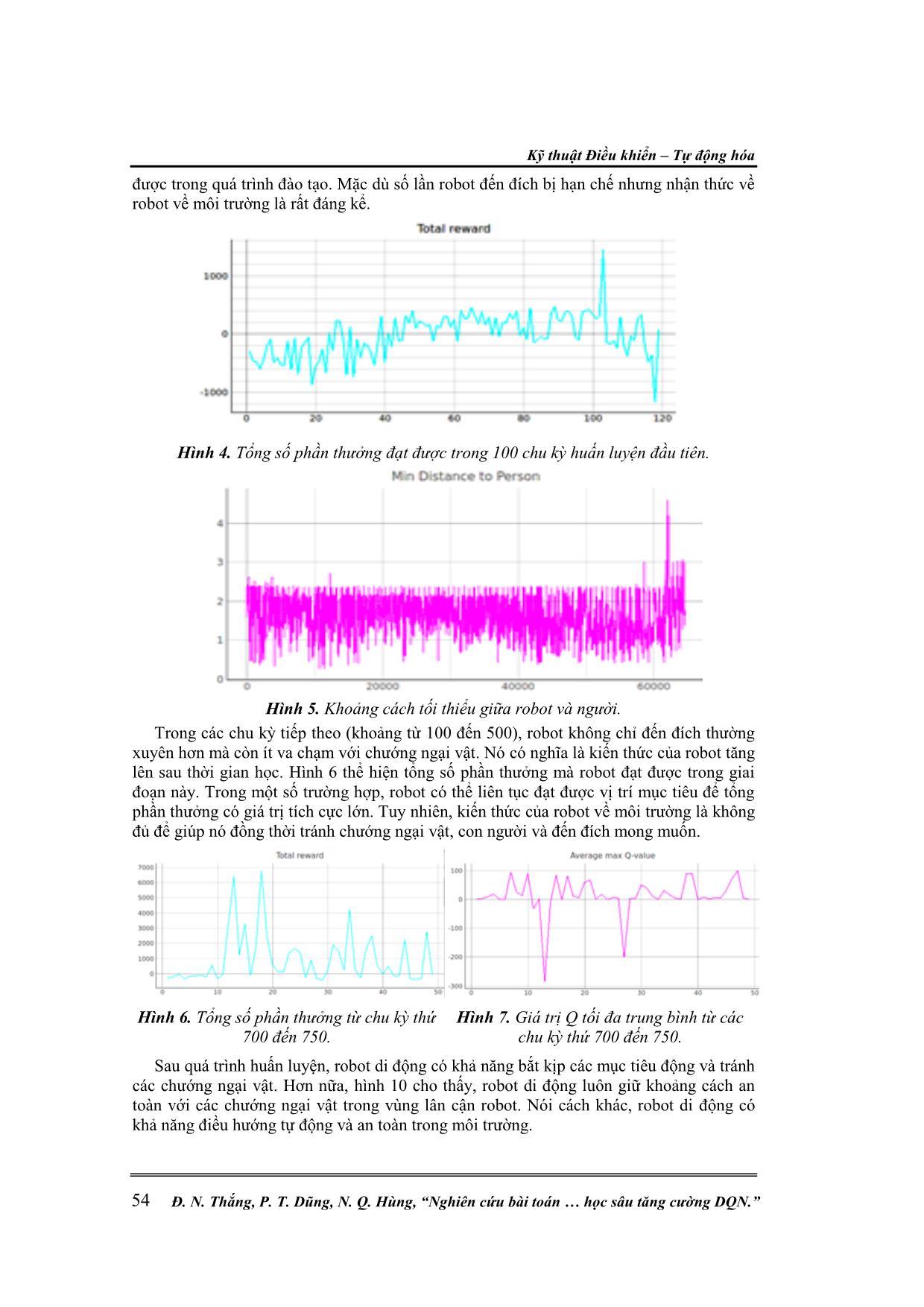

Trong các chu kỳ tiếp theo (khoảng từ 100 đến 500), robot không chỉ đến đích thường

xuyên hơn mà còn ít va chạm với chướng ngại vật. Nó có nghĩa là kiến thức của robot tăng

lên sau thời gian học. Hình 6 thể hiện tổng số phần thưởng mà robot đạt được trong giai

đoạn này. Trong một số trường hợp, robot có thể liên tục đạt được vị trí mục tiêu để tổng

phần thưởng có giá trị tích cực lớn. Tuy nhiên, kiến thức của robot về môi trường là không

đủ để giúp nó đồng thời tránh chướng ngại vật, con người và đến đích mong muốn.

Hình 6. Tổng số phần thưởng từ chu kỳ thứ

700 đến 750.

Hình 7. Giá trị Q tối đa trung bình từ các

chu kỳ thứ 700 đến 750.

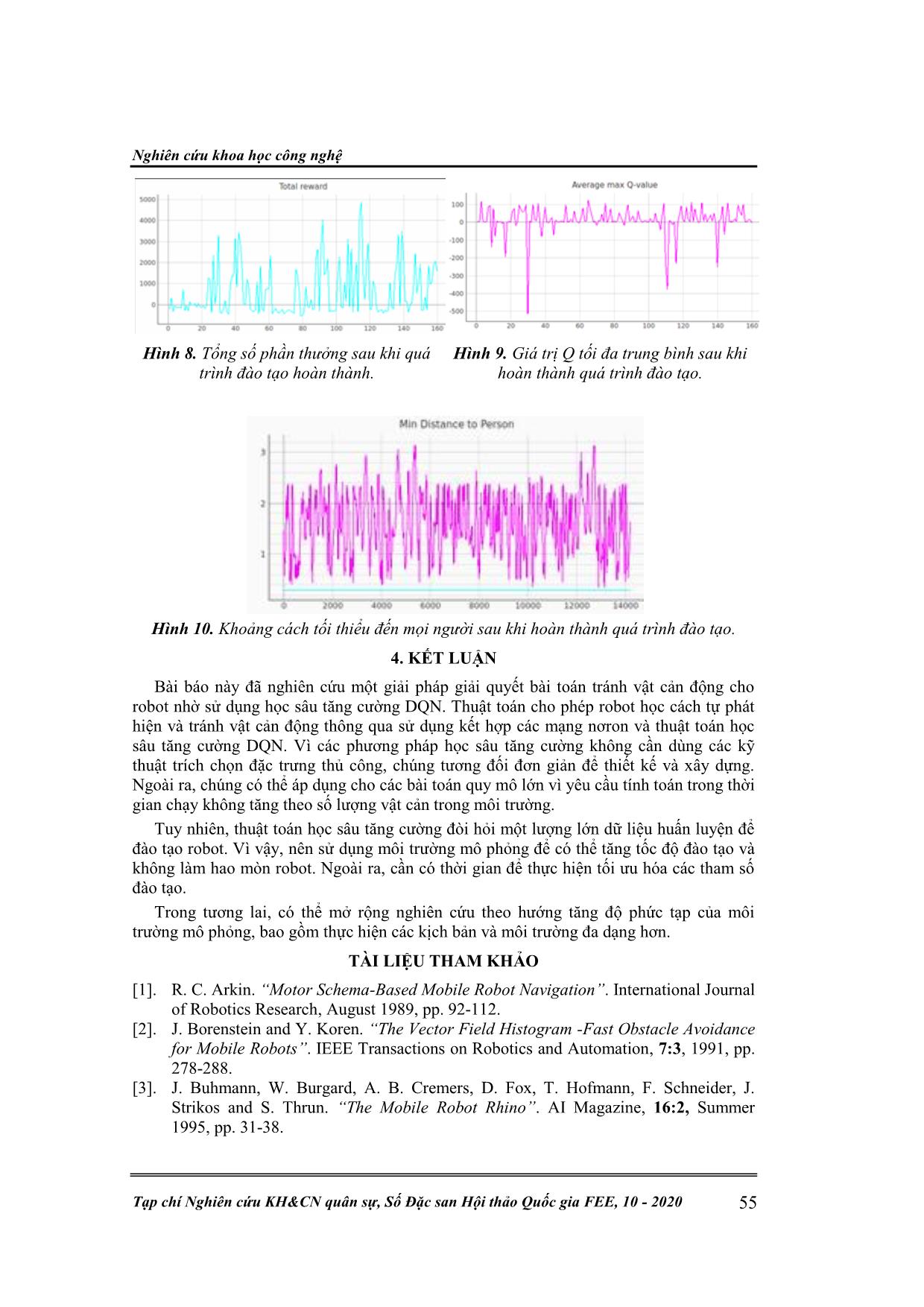

Sau quá trình huấn luyện, robot di động có khả năng bắt kịp các mục tiêu động và tránh

các chướng ngại vật. Hơn nữa, hình 10 cho thấy, robot di động luôn giữ khoảng cách an

toàn với các chướng ngại vật trong vùng lân cận robot. Nói cách khác, robot di động có

khả năng điều hướng tự động và an toàn trong môi trường.

Nghiên cứu khoa học công nghệ

Tạp chí Nghiên cứu KH&CN quân sự, Số Đặc san Hội thảo Quốc gia FEE, 10 - 2020 55

Hình 8. Tổng số phần thưởng sau khi quá

trình đào tạo hoàn thành.

Hình 9. Giá trị Q tối đa trung bình sau khi

hoàn thành quá trình đào tạo.

Hình 10. Khoảng cách tối thiểu đến mọi người sau khi hoàn thành quá trình đào tạo.

4. KẾT LUẬN

Bài báo này đã nghiên cứu một giải pháp giải quyết bài toán tránh vật cản động cho

robot nhờ sử dụng học sâu tăng cường DQN. Thuật toán cho phép robot học cách tự phát

hiện và tránh vật cản động thông qua sử dụng kết hợp các mạng nơron và thuật toán học

sâu tăng cường DQN. Vì các phương pháp học sâu tăng cường không cần dùng các kỹ

thuật trích chọn đặc trưng thủ công, chúng tương đối đơn giản để thiết kế và xây dựng.

Ngoài ra, chúng có thể áp dụng cho các bài toán quy mô lớn vì yêu cầu tính toán trong thời

gian chạy không tăng theo số lượng vật cản trong môi trường.

Tuy nhiên, thuật toán học sâu tăng cường đòi hỏi một lượng lớn dữ liệu huấn luyện để

đào tạo robot. Vì vậy, nên sử dụng môi trường mô phỏng để có thể tăng tốc độ đào tạo và

không làm hao mòn robot. Ngoài ra, cần có thời gian để thực hiện tối ưu hóa các tham số

đào tạo.

Trong tương lai, có thể mở rộng nghiên cứu theo hướng tăng độ phức tạp của môi

trường mô phỏng, bao gồm thực hiện các kịch bản và môi trường đa dạng hơn.

TÀI LIỆU THAM KHẢO

[1]. R. C. Arkin. “Motor Schema-Based Mobile Robot Navigation”. International Journal

of Robotics Research, August 1989, pp. 92-112.

[2]. J. Borenstein and Y. Koren. “The Vector Field Histogram -Fast Obstacle Avoidance

for Mobile Robots”. IEEE Transactions on Robotics and Automation, 7:3, 1991, pp.

278-288.

[3]. J. Buhmann, W. Burgard, A. B. Cremers, D. Fox, T. Hofmann, F. Schneider, J.

Strikos and S. Thrun. “The Mobile Robot Rhino”. AI Magazine, 16:2, Summer

1995, pp. 31-38.

Kỹ thuật Điều khiển – Tự động hóa

Đ. N. Thắng, P. T. Dũng, N. Q. Hùng, “Nghiên cứu bài toán học sâu tăng cường DQN.” 56

[4]. P. Jacobs and J. Canny. “Planning Smooth Paths for Mobile Robots”. In Proc. IEEE

Intl. Conference on Robotics and Automation, Scottsdale AZ, May 1989, pp. 2-7.

[5]. W. Feiten, R. Bauer and G. Lawitzky. “Robust Obstacle Avoidance in Unknown and

Cramped Environments”. In Proc. IEEE Intl. Conference on Robotics and

Automation, San Diego, CA, May 1994, pp. 2412-2417.

[6]. D. Fox, W. Burgard and S. Thrun. “The Dynamic Window Approach to Collision

Avoidance”. Tech Report IAI-TR-95-13, CS Department, University of Bonn, 1995.

[7]. A. Kelly. “An Intelligent Predictive Control Approach to the High Speed Cross

Country Autonomous Navigation Problem”, Tech Report CMU-CS-TR-95-33,

School of Computer Science, Carnegie Mellon University, 1995.

[8]. O. Khatib. “Real-time Obstacle Avoidance for Manipulators and Mobile Robots”. In

Proc. IEEE Intl. Conference on Robotics and Automation, St. Louis, MO, March

1985, pp. 500-505.

[9]. J. C. Latombe. “Robot Motion Planning”. Kluwer Academic Publishers, 1991.

[10]. R. Simmons. “The curvature-velocity method for local obstacle avoidance”, In

Proceeding of IEEE international Conference on Robotics and Automation,

August 2002.

[11]. Xuan Tung Truong, Yong Sheng Ou, and Trung-Dung Ngo, “Towards Culturally

Aware Robot Navigation”, IEEE International Conference on Realtime Computing

and Robotics, 2016.

[12]. Guo-Sheng Yang, Er-Kui Chen, and Cheng-Wan An, “Mobile Robot Navigation

using Neural Q-learning”, Third International Conference on Machine Learning and

Cybernetics, Shanghai, 2004.

ABSTRACT

RESEARCHING THE PROBLEM OF AVOIDING OBSTACLES

FOR AUTO MOBILE ROBOTS BASED ON THE DEEP Q LEARNING

The problem of avoiding obstacles for auto mobile robots based on the

application of artificial intelligence tools is a researching direction in the field of

the intelligent robot control. In this paper, the behavioral prediction and the DQN

(Deep Q learning) technique have been solved. The autonomous robots in the

research are under control by 2-wheels independently. The results show the

effectiveness of the approach, the robot can predict the next activities basing on the

previous one without the robot modeling.

Keywords: Autonomous mobile robot; Proactive collision avoidance; DQN algorithm; Turtlebot3.

Nhận bài ngày 03 tháng 8 năm 2020

Hoàn thiện ngày 05 tháng 10 năm 2020

Chấp nhận đăng ngày 05 tháng 10 năm 2020

Địa chỉ: 1Viện Khoa học và Công nghệ quân sự;

2Học viện Kỹ thuật quân sự.

*

Email: thangdonam@gmail.com.

File đính kèm:

nghien_cuu_bai_toan_tranh_vat_can_cho_ro_bot_tu_hanh_tren_co.pdf

nghien_cuu_bai_toan_tranh_vat_can_cho_ro_bot_tu_hanh_tren_co.pdf